摘要:AI与大数据算法不断发展,在生产中的应用也越来越广,而应用的场景除了对算法,软件架构要求越来越高外,也对底层IaaS(基础设施即服务)提出了新的挑战。

AI与大数据算法不断发展,在生产中的应用也越来越广,而应用的场景除了对算法,软件架构要求越来越高外,也对底层IaaS(基础设施即服务)提出了新的挑战。在7月8日的华为云开发者大会2023(Cloud)-云原生分论坛“从大数据到AI,华为云存储加速企业大模型快速应用”上,华为云存储服务产品部部长林超、叮咚买菜技术副总裁周祥军、趣丸科技数据服务负责人黄强、华为云存储服务产品部高级架构师姚博士等嘉宾分别分享了他们的见解。

林超结合他对业界的洞察,提出了华为云对大数据与AI时代存储服务的定义:「具备存算分离能力,提供多级加速与海量数据存储能力的高性价比存储底座」

在训练场景,用于训练的数据越来越多,L2级自动驾驶训练就需要400PB路采数据,而L3级别自动驾驶训练所需的路采数据量更为惊人。随着训练的数据量成倍增加,训练时元数据预热时间也变得越来越长,2023年车厂在进行L3级别自动驾驶训练时每次元数据预热的时间超过10小时,GPU长时间空载,造成算力大量浪费,而且在训练时GPU集群需要已亚ms的速度不断读取数据进行训练,这对存储的性能也是极大的挑战。另外,由于当前AI训练是以GPU卡为核心展开的,而客户的GPU卡往往既在线下部署也在线上部署,如何快速高效的为多元化部署的GPU提供数据存储服务也是一件非常有挑战的事。

在推理场景,随着AI在生产生活中的使用越来越广泛,AI已经成为社会高效运转的必要环节,人们对AI处理的速度要求越来越高。当前AI大模型一般是通用大模型,缺乏行业Know How,在面对特定领域、行业的需求时往往无法给出最优解,这给大模型在行业适配落地带来了很大的困难。另外随着AIGC在内容生产的占比越来越高,AIGC所带来的法律、道德、合规风险越来越大,如果不加以管理,AI必将成为不良内容滋生的温床。

针对上述挑战,华为云提出了其应对方案:

在AI训练环节,数据经过采集、上云、预处理、标注进入模型训练环节,模型再通过数据仿真、模型评估、模型部署进入推理环节。

华为云存储首先通过OBS对象存储构建统一数据湖来承载EB级海量的训练数据,并通过基于多种存储规格的数据智能分级功能降低50%的存储成本。同时OBS通过Posix语义支持预处理等环节,从而减少整个训练环节中数据在不同类型存储中传输的次数,提升整体效率。

同时在模型训练的关键环节,GPU集群对存储的性能有着极高的要求,华为云存储通过SFS Turbo在OBS统一数据与GPU集群之间构建高效加速层,提升AI训练效率,通过高效加速层,原本需要上百小时的元数据预热时间被缩短至30分钟,有效减少了GPU空闲时间。同时在训练中的数据读取时延也降低到了亚毫秒级别,训练效率相比直接对接数据湖提升3倍以上。而且SFS Turbo支持贴近GPU在线上、线下多元化部署,满足数据就近加速的需求。

在推理阶段,华为云存储重点优化了推理成本、推理性能、行业落地、内容合规三个痛点

通过构建弹性缓存,推理过程不在需要通过增加GPU在扩展内存,从而达到将大模型装载到内存的目的,弹性缓存池可以按需提供高性能的缓存空间,满足大模型的加载需求。行业落地的痛点是解决行业Know How的问题,如果使用私域数据、行业数据等对大模型进行重新训练,那么高昂的成本和漫长的时间都是客户无法承担的,通过引入向量存储,相当于在大模型的外面增加了行业Know How的外挂,无需重新训练大模型即可满足行业需求,而且部分问题在向量存储中即可闭环,无需推理,使得整个推理性能大幅提升100倍,而成本却降低了10倍。另外华为DWR数据工坊提供了全面的内容审核服务,可以确保AI推理所输出的内容满足合规要求,避免了由于使用AI带来的业务风险。

随后,叮咚买菜技术副总裁周祥军、趣丸科技数据服务负责人黄强、华为云存储服务产品部高级架构师姚博士也分别演讲了自己的见解。

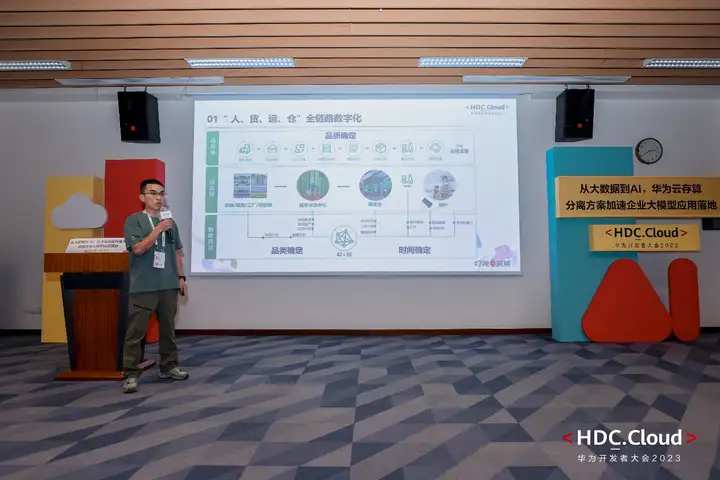

周祥军的演讲主题为“云上叮咚,用科技让人们吃得好,让生活更美好”,在此议题中,他分享了叮咚买菜在华为云上的大数据能力建设案例,叮咚买菜通过运筹优化车辆线路调度,最终实现了品质确定、品类确定、时间确定的“人、货、运、仓”全链路数字化。

黄强分享了趣丸科技大数据+云原生加持下的用户运营系统建设,趣丸科技为解决用户运营过程中的触点多、数据量大、不确定性高和个性化诉求强的问题,最终利用大数据与云原生技术,提高了运营效率,保障了运营质量。

姚博士则从技术架构角度解读了华为云存储的一站式数据管理、存储、加速方案。华为云通过SFS Turbo与OBS联动提供了大容量、高可靠、低成本的数据持久化层和高效的缓存加速层。作为AI训练加速器的SFS Turbo通过MDS Turbo、CAT Cache和全路径软硬件优化的极致时延数据流传,最终实现了百万级 IOPS 的元数据加速,降低了训练过程中训练数据和checkpoint的读写时延,解决了百亿小文件的预热与数据加载加速问题。