大侠幸会,在下全网同名「算法金」 0 基础转 AI 上岸,多个算法赛 Top 「日更万日,让更多人享受智能乐趣」

在机器学习和数据科学的江湖中,评估模型的好坏是非常关键的一环。而 ROC(Receiver Operating Characteristic)曲线和 AUC(Area Under Curve)正是评估分类模型性能的重要工具。

这个知识点在面试中也很频繁的出现。尽管理解这些概念本身不难,但许多人在复习时容易混淆,或在面试紧张时忘记,影响回答效果。

本篇文章将会从基础概念入手,逐步深入到实际操作。我们会详细解释 ROC 曲线和 AUC 的定义和意义,通过实例和代码示范帮助大侠掌握这些工具的使用方法,最后通过一些实际应用案例和相关概念的对比,力求全面理解并灵活运用 ROC 和 AUC。

ROC 曲线,即接收者操作特征曲线,ROC曲线产生于第二次世界大战期间,最早用在信号检测领域,侦测战场上的敌军载具(飞机、船舰)。现在是是用来评价二分类模型性能的常用图形工具。它通过显示真阳性率(True Positive Rate,简称 TPR)与假阳性率(False Positive Rate,简称 FPR)之间的权衡来帮助我们理解模型的分类能力。

AUC,即曲线下面积(Area Under Curve),是 ROC 曲线下面积的一个数值表示。它提供了一个定量的指标,用来衡量分类模型的整体表现。AUC 值范围从 0 到 1,值越大表示模型性能越好。

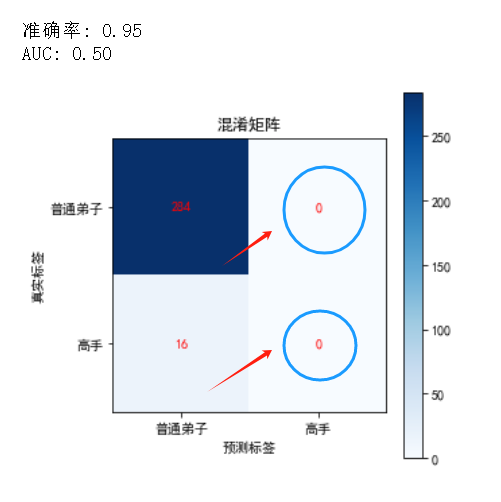

在分类任务中,特别是当数据集类别不平衡时,单纯依赖准确率(Accuracy)可能会造成误导。为了更好地理解这一点,让我们通过一个例子来说明。

例子说明

假设我们有一个武侠元素的数据集,其中 95% 的样本是普通弟子,5% 的样本是高手。

让我们通过代码示例来演示这一点(代码供复现使用,可直接跳过下滑到解释部分):

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from sklearn.metrics import roc_curve, roc_auc_score, accuracy_score, confusion_matrix

# 生成一个极度不平衡的武侠数据集

# 假设特征表示武功修炼时间、战斗胜率等,标签表示是否为高手

X, y = make_classification(n_samples=1000, n_features=20, n_classes=2, weights=[0.95, 0.05], random_state=42)

# 将数据集分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 创建一个总是预测普通弟子的模型

class AlwaysNegativeModel:

def predict(self, X):

return np.zeros(X.shape[0])

# 训练和预测

model = AlwaysNegativeModel()

y_pred = model.predict(X_test)

# 计算混淆矩阵和准确率

cm = confusion_matrix(y_test, y_pred)

accuracy = accuracy_score(y_test, y_pred)

# 计算 ROC 曲线和 AUC

# 在这里我们需要一个概率预测来计算 ROC 曲线和 AUC,为了演示,我们假设模型输出的是一个常量概率

y_pred_prob = np.zeros(X_test.shape[0])

fpr, tpr, thresholds = roc_curve(y_test, y_pred_prob)

auc = roc_auc_score(y_test, y_pred_prob)

# 可视化结果

plt.figure(figsize=(10, 5))

plt.subplot(1, 2, 1)

plt.title("混淆矩阵")

plt.imshow(cm, interpolation='nearest', cmap=plt.cm.Blues)

plt.colorbar()

plt.xlabel("预测标签")

plt.ylabel("真实标签")

plt.xticks([0, 1], ["普通弟子", "高手"])

plt.yticks([0, 1], ["普通弟子", "高手"])

for i in range(2):

for j in range(2):

plt.text(j, i, cm[i, j], ha="center", va="center", color="red")

print(f"准确率: {accuracy:.2f}")

print(f"AUC: {auc:.2f}")

结果分析

如果我们使用一个简单的分类器,它总是预测所有样本为普通弟子。

这个模型的准确率为 95%,看起来表现很好,但实际上它根本无法识别高手,是一个毫无用处的分类器。

这个分类器没有任何实际的分类能力,因为它无法识别出真正的高手。

准确率只告诉我们模型整体预测正确的比例,但在类别不平衡的情况下,这个指标可能会误导我们。ROC 曲线和 AUC 提供了更全面的视角,展示了模型在不同阈值下的性能,帮助我们更准确地评估模型的分类能力。

更多内容,见免费知识星球

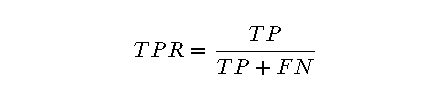

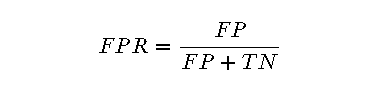

要理解 ROC 曲线,首先需要明白 TPR 和 FPR 的概念:

其中,TP(True Positives)是将正类正确分类为正类的样本数,FN(False Negatives)是将正类错误分类为负类的样本数。

其中,FP(False Positives)是将负类错误分类为正类的样本数,TN(True Negatives)是将负类正确分类为负类的样本数。

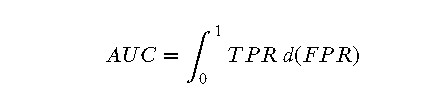

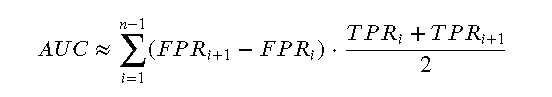

AUC(Area Under Curve)是 ROC 曲线下的面积,用于评估分类模型的性能。AUC 值的范围从 0 到 1,值越大表示模型的性能越好。

数学上,AUC 可以通过积分计算:

在离散情况下,AUC 可以通过梯形法则近似计算:

绘制 ROC 曲线的步骤如下:

from sklearn.metrics import roc_curve

# 预测测试集概率

y_pred_prob = model.predict_proba(X_test)[:, 1]

# 计算 ROC 曲线

fpr, tpr, thresholds = roc_curve(y_test, y_pred_prob)

# 输出部分阈值

print("阈值: ", thresholds[:10]) # 仅展示前10个阈值

# 输出部分阈值对应的 TPR 和 FPR

for i in range(10): # 仅展示前10个阈值的对应值

print(f"阈值: {thresholds[i]:.2f} -> 假阳性率 (FPR): {fpr[i]:.2f}, 真阳性率 (TPR): {tpr[i]:.2f}")

import matplotlib.pyplot as plt

# 可视化 ROC 曲线

plt.figure(figsize=(8, 6))

plt.plot(fpr, tpr, color='blue', lw=2, label='ROC 曲线')

plt.plot([0, 1], [0, 1], color='gray', lw=1, linestyle='--', label='随机猜测')

plt.xlabel("假阳性率 (FPR)")

plt.ylabel("真阳性率 (TPR)")

plt.title("ROC 曲线")

plt.legend(loc="lower right")

# 在曲线上标出几个阈值点

threshold_points = [0.2, 0.5, 0.8]

for threshold in threshold_points:

idx = np.where(thresholds >= threshold)[0][0]

plt.scatter(fpr[idx], tpr[idx], marker='o', color='red')

plt.text(fpr[idx], tpr[idx], f"阈值={threshold:.2f}", fontsize=12)

plt.show()

AUC 值越大,模型的性能越好。具体来说:

下面我们通过代码示例来计算 AUC 并解释其意义:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import roc_curve, roc_auc_score, accuracy_score, confusion_matrix

# 生成一个不平衡的武侠数据集

# 假设特征表示武功修炼时间、战斗胜率等,标签表示是否为高手

X, y = make_classification(n_samples=1000, n_features=20, n_classes=2, weights=[0.9, 0.1], random_state=42)

# 将数据集分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 训练一个逻辑回归模型

model = LogisticRegression()

model.fit(X_train, y_train)

# 预测测试集

y_pred_prob = model.predict_proba(X_test)[:, 1]

# 计算 ROC 曲线和 AUC

fpr, tpr, thresholds = roc_curve(y_test, y_pred_prob)

auc = roc_auc_score(y_test, y_pred_prob)

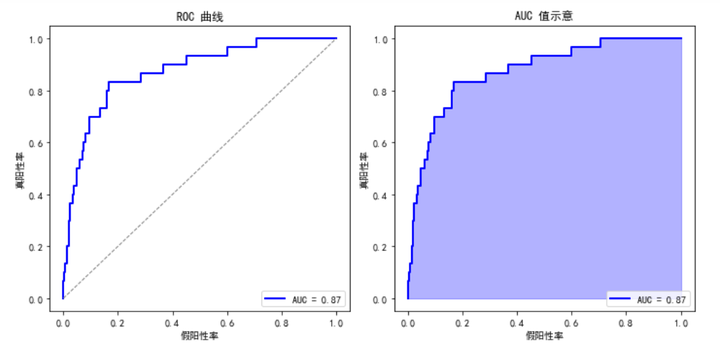

# 可视化结果

plt.figure(figsize=(10, 5))

plt.subplot(1, 2, 1)

plt.title("ROC 曲线")

plt.plot(fpr, tpr, color='blue', lw=2, label=f"AUC = {auc:.2f}")

plt.plot([0, 1], [0, 1], color='gray', lw=1, linestyle='--')

plt.xlabel("假阳性率")

plt.ylabel("真阳性率")

plt.legend(loc="lower right")

plt.subplot(1, 2, 2)

plt.title("AUC 值示意")

plt.fill_between(fpr, tpr, color='blue', alpha=0.3)

plt.plot(fpr, tpr, color='blue', lw=2, label=f"AUC = {auc:.2f}")

plt.xlabel("假阳性率")

plt.ylabel("真阳性率")

plt.legend(loc="lower right")

plt.tight_layout()

plt.show()

print(f"AUC: {auc:.2f}")

通过这两个图,可以直观地看到模型在不同阈值下的分类性能,以及通过 AUC 值来量化这种性能。

为了让大侠更好地理解 ROC 和 AUC 在实际中的应用,我们将展示它们在不同领域中的应用,如医学诊断和金融风险评估,并通过实际案例进行代码实现。

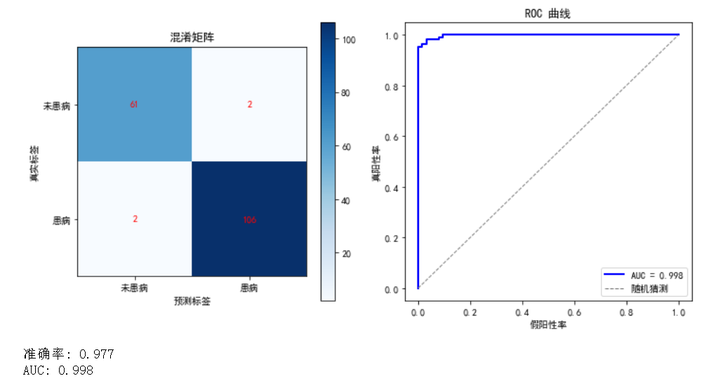

医学诊断

在医学诊断中,ROC 曲线和 AUC 被广泛用于评估诊断测试的性能。例如,在筛查癌症时,医生希望测试能够正确识别出患病和未患病的患者。ROC 曲线可以帮助医生选择最佳的阈值,从而最大化检测的准确性。

金融风险评估

在金融领域,ROC 和 AUC 被用于评估信用评分模型的性能。例如,银行希望识别高风险借款人,以降低贷款违约率。ROC 曲线可以帮助银行选择适当的阈值,以平衡风险和收益。

我们将使用一个模拟的医学诊断数据集来演示如何应用 ROC 和 AUC。假设我们有一个数据集,包含患者的各种特征以及他们是否患有某种疾病。

代码示例和结果分析

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import load_breast_cancer

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import roc_curve, roc_auc_score, accuracy_score, confusion_matrix

# 加载乳腺癌数据集

data = load_breast_cancer()

X = data.data

y = data.target

# 将数据集分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 训练一个逻辑回归模型

model = LogisticRegression(max_iter=10000)

model.fit(X_train, y_train)

# 预测测试集

y_pred = model.predict(X_test)

y_pred_prob = model.predict_proba(X_test)[:, 1]

# 计算混淆矩阵和准确率

cm = confusion_matrix(y_test, y_pred)

accuracy = accuracy_score(y_test, y_pred)

# 计算 ROC 曲线和 AUC

fpr, tpr, thresholds = roc_curve(y_test, y_pred_prob)

auc = roc_auc_score(y_test, y_pred_prob)

# 可视化结果

plt.figure(figsize=(10, 5))

plt.subplot(1, 2, 1)

plt.title("混淆矩阵")

plt.imshow(cm, interpolation='nearest', cmap=plt.cm.Blues)

plt.colorbar()

plt.xlabel("预测标签")

plt.ylabel("真实标签")

plt.xticks([0, 1], ["未患病", "患病"])

plt.yticks([0, 1], ["未患病", "患病"])

for i in range(2):

for j in range(2):

plt.text(j, i, cm[i, j], ha="center", va="center", color="red")

plt.subplot(1, 2, 2)

plt.title("ROC 曲线")

plt.plot(fpr, tpr, color='blue', lw=2, label=f"AUC = {auc:.2f}")

plt.plot([0, 1], [0, 1], color='gray', lw=1, linestyle='--', label='随机猜测')

plt.xlabel("假阳性率")

plt.ylabel("真阳性率")

plt.legend(loc="lower right")

plt.tight_layout()

plt.show()

print(f"准确率: {accuracy:.2f}")

print(f"AUC: {auc:.2f}")

结果分析

解释

在这部分内容中,我们将对 ROC/AUC 与其他评估指标进行对照和对比,以便大侠更全面地理解这些指标在模型评估中的作用。

混淆矩阵是一种用来评价分类模型性能的工具,它通过展示真阳性(TP)、假阳性(FP)、真阴性(TN)和假阴性(FN)的数量来评估模型。ROC 曲线和 AUC 则是从不同的阈值下综合评估模型的性能。

示例代码:

from sklearn.metrics import confusion_matrix, accuracy_score

# 预测测试集

y_pred = model.predict(X_test)

y_pred_prob = model.predict_proba(X_test)[:, 1]

# 计算混淆矩阵

cm = confusion_matrix(y_test, y_pred)

accuracy = accuracy_score(y_test, y_pred)

# 输出混淆矩阵和准确率

print("混淆矩阵:")

print(cm)

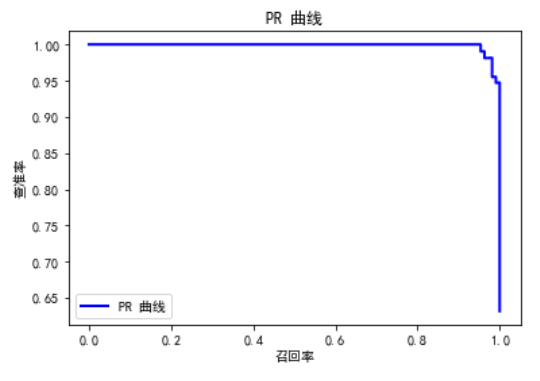

PR 曲线(Precision-Recall Curve)是另一种评估二分类模型的方法,特别适用于不平衡数据集。它通过展示查准率(Precision)和召回率(Recall)之间的关系来评估模型性能。

示例代码:

from sklearn.metrics import precision_recall_curve

# 计算 PR 曲线

precision, recall, _ = precision_recall_curve(y_test, y_pred_prob)

# 可视化 PR 曲线

plt.figure()

plt.plot(recall, precision, color='blue', lw=2, label='PR 曲线')

plt.xlabel("召回率")

plt.ylabel("查准率")

plt.title("PR 曲线")

plt.legend(loc="lower left")

plt.show()

除了 ROC/AUC 和 PR 曲线,其他常用的评估指标还有:

示例代码:

from sklearn.metrics import precision_score, recall_score, f1_score

# 计算查准率、召回率和 F1 分数

precision = precision_score(y_test, y_pred)

recall = recall_score(y_test, y_pred)

f1 = f1_score(y_test, y_pred)

# 输出结果

print(f"查准率: {precision:.2f}")

print(f"召回率: {recall:.2f}")

print(f"F1 分数: {f1:.2f}")

在使用 ROC 和 AUC 评估分类模型性能时,大侠需要注意一些常见的误区和使用注意事项,以便准确地理解和应用这些指标。

高准确率并不一定意味着模型性能优秀,尤其是在类别不平衡的情况下。正如前文所示,即使一个模型总是预测为大多数类,其准确率也可能很高,但其实际分类能力可能非常差。

虽然 AUC 值高表示模型性能好,但在某些应用场景下,其他指标如查准率(Precision)和召回率(Recall)可能更加重要。例如,在医疗诊断中,召回率(即灵敏度)通常比 AUC 更加关键,因为漏诊的代价非常高。

依赖单一指标评价模型性能是不全面的。最好结合多个指标(如 AUC、准确率、查准率、召回率和 F1 分数)来综合评估模型的性能。

在处理类别不平衡的数据集时,AUC 和 ROC 曲线可以提供更全面的评估,但仍需要结合 PR 曲线等其他指标进行综合分析。

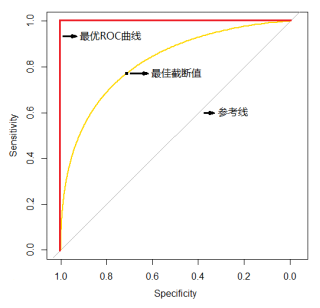

ROC 曲线展示了模型在不同阈值下的性能表现,需要根据具体应用场景选择合适的阈值。例如,在金融风险评估中,选择较低的阈值可能会增加风险,但可以减少漏检。

确保模型的概率输出是校准的,即输出的概率与实际发生的概率一致。模型校准可以通过可靠性图(Calibration Curve)等方法进行评估和调整。

经过前面的详细讲解,我们已经全面了解了 ROC 曲线和 AUC 的概念、计算方法、代码实现以及在不同领域中的应用。下面对文章的核心内容进行简要回顾:

通过这篇文章的讲解,希望大侠们能够更加全面地理解和应用 ROC 曲线和 AUC,在实际项目中灵活运用这些知识,提升模型评估的准确性和可靠性。

- 科研为国分忧,创新与民造福 -

日更时间紧任务急,难免有疏漏之处,还请大侠海涵 内容仅供学习交流之用,部分素材来自网络,侵联删

如果觉得内容有价值,烦请大侠多多 分享、在看、点赞,助力算法金又猛又持久、很黄很 BL 的日更下去;

同时邀请大侠 关注、星标 算法金,围观日更万日,助你功力大增、笑傲江湖