大侠幸会,在下全网同名「算法金」

0 基础转 AI 上岸,多个算法赛 Top

「日更万日,让更多人享受智能乐趣」

最近,有读者参加了腾讯算法岗位的面试,面试着重考察了基础知识,并且提问非常详细。

特别是关于AdaBoost算法的问题,面试官问了很多。

今天,我们就来和大家探讨一下 AdaBoost 算法的相关知识。

Adaboost,全称为 Adaptive Boosting,由 Freund 和 Schapire 于 1996 年提出,是一种迭代的机器学习算法。Adaboost 的核心思想是通过组合多个弱分类器(weak classifiers),构建一个强分类器(strong classifier)。这种方法在各种应用场景中取得了显著的成功,尤其在分类问题上表现突出。

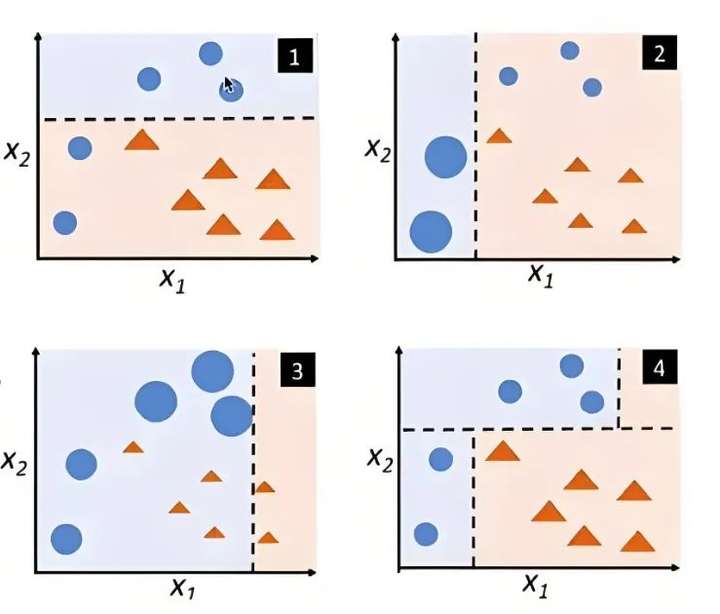

Adaboost 的基本思想是根据上一次分类器的错误率,调整训练样本的权重,使得那些被错误分类的样本在后续的分类器中得到更多的关注。通过不断迭代和调整权重,最终得到一个综合了多个弱分类器的强分类器。

Adaboost 是一种集成学习方法,集成了多个弱分类器来提高整体的分类性能。每个弱分类器的权重根据其分类准确度进行调整。

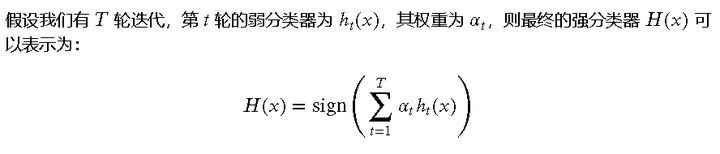

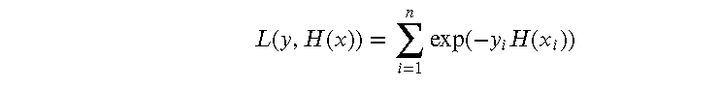

Adaboost 的工作原理可以分为以下几个步骤:

Adaboost 对弱分类器的选择没有严格的限制,可以使用决策树、线性分类器等。在实践中,决策树桩(决策树深度为1)常被用作弱分类器。

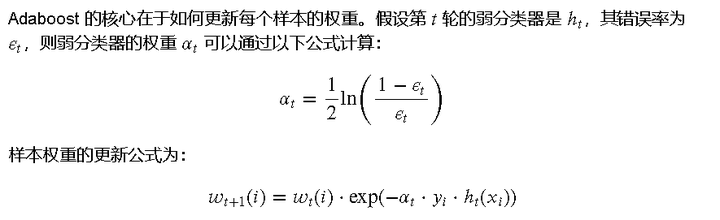

Adaboost 的核心在于通过多次迭代训练弱分类器并组合这些弱分类器来构建一个强分类器。在每次迭代中,算法会调整样本的权重,使得那些被误分类的样本在后续的迭代中得到更多的关注。

Adaboost 使用指数损失函数来衡量分类错误的程度。损失函数的形式为:

为了更好地理解 Adaboost 的数学基础,我们将在代码中实现这些公式。

import numpy as np

# 初始化样本权重

n_samples = 100

weights = np.ones(n_samples) / n_samples

# 假设我们有两个简单的弱分类器

def weak_classifier_1(x):

return np.where(x[:, 0] > 0, 1, -1)

def weak_classifier_2(x):

return np.where(x[:, 1] > 0, 1, -1)

# 模拟训练数据

X = np.random.randn(n_samples, 2)

y = np.where(X[:, 0] + X[:, 1] > 0, 1, -1)

# 第一次迭代

pred_1 = weak_classifier_1(X)

error_1 = np.sum(weights * (pred_1 != y)) / np.sum(weights)

alpha_1 = 0.5 * np.log((1 - error_1) / error_1)

weights = weights * np.exp(-alpha_1 * y * pred_1)

weights /= np.sum(weights)

# 第二次迭代

pred_2 = weak_classifier_2(X)

error_2 = np.sum(weights * (pred_2 != y)) / np.sum(weights)

alpha_2 = 0.5 * np.log((1 - error_2) / error_2)

weights = weights * np.exp(-alpha_2 * y * pred_2)

weights /= np.sum(weights)

# 最终分类器

H = alpha_1 * weak_classifier_1(X) + alpha_2 * weak_classifier_2(X)

final_pred = np.sign(H)

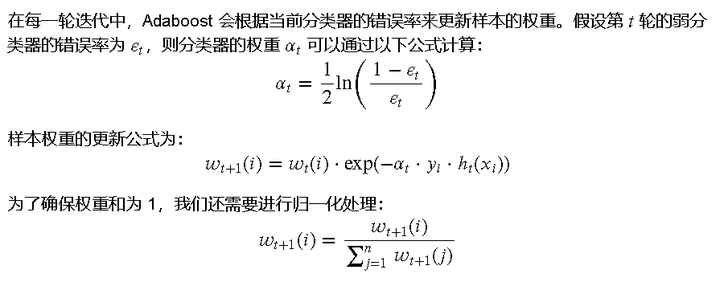

在这一部分,我们将使用一个内置的经典数据集——鸢尾花数据集(Iris Dataset)。这个数据集包含了三类鸢尾花的特征,常用于分类算法的演示。

from sklearn.datasets import load_iris

import matplotlib.pyplot as plt

import seaborn as sns

# 加载鸢尾花数据集

iris = load_iris()

X = iris.data

y = iris.target

# 数据集可视化

sns.pairplot(sns.load_dataset("iris"), hue="species")

plt.show()

说明:

我们将使用 Scikit-learn 的 AdaBoostClassifier 来实现 Adaboost 算法,并进行训练和预测。

from sklearn.ensemble import AdaBoostClassifier

from sklearn.tree import DecisionTreeClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score, classification_report, confusion_matrix

import pandas as pd

import seaborn as sns

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 初始化 Adaboost 分类器

adaboost = AdaBoostClassifier(

base_estimator=DecisionTreeClassifier(max_depth=1),

n_estimators=50,

learning_rate=1.0,

random_state=42

)

# 训练模型

adaboost.fit(X_train, y_train)

# 预测

y_pred = adaboost.predict(X_test)

# 计算准确率

accuracy = accuracy_score(y_test, y_pred)

print(f'分类准确率: {accuracy:.2f}')

说明:

运行后输出:

分类准确率: 1.00

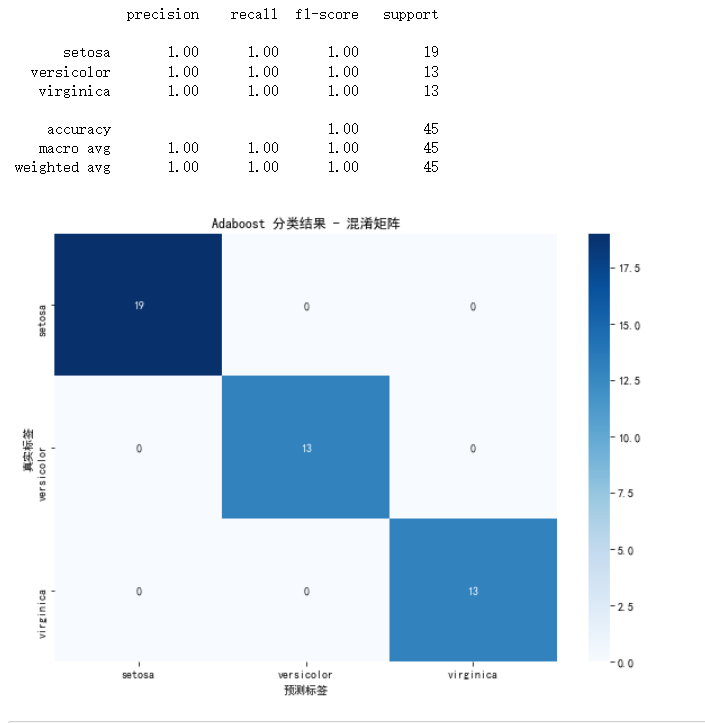

我们将进一步分析模型的性能,包括分类报告和混淆矩阵,并对结果进行可视化。

# 打印分类报告

print(classification_report(y_test, y_pred, target_names=iris.target_names))

# 混淆矩阵

conf_matrix = confusion_matrix(y_test, y_pred)

conf_matrix_df = pd.DataFrame(conf_matrix, index=iris.target_names, columns=iris.target_names)

# 混淆矩阵可视化

plt.figure(figsize=(10, 7))

sns.heatmap(conf_matrix_df, annot=True, cmap='Blues')

plt.title('Adaboost 分类结果 - 混淆矩阵')

plt.xlabel('预测标签')

plt.ylabel('真实标签')

plt.show()

说明:

通过代码示范和结果分析,我们可以直观地了解 Adaboost 算法的实现过程及其在分类问题上的表现。

在本文中,我们详细介绍了 Adaboost 算法的核心概念和应用。首先,我们了解了 Adaboost 的起源和基本思想。接着,我们深入探讨了 Adaboost 的工作原理、算法步骤、权重更新机制和弱分类器的选择,并通过代码示范展示了其具体实现过程。

我们还介绍了 Adaboost 的数学基础,包括算法公式、损失函数和权重更新公式,使大侠们对其理论有了更深入的理解。在代码示范部分,我们结合武侠元素的数据集,详细展示了 Adaboost 算法在实际应用中的操作步骤,并对结果进行了可视化和分析。

随后,我们讨论了 Adaboost 的优缺点及其适用场景,帮助大侠们在实际应用中更好地评估和选择该算法。最后,通过具体的经典应用案例,如图像识别和文本分类,我们展示了 Adaboost 在不同领域的强大能力和广泛应用。

希望通过本文的介绍,大侠们能够更全面地了解和掌握 Adaboost 算法,在今后的学习和实践中,灵活运用这一强大的机器学习工具。

如果觉得内容有价值,烦请大侠多多 分享、在看、点赞,助力算法金又猛又持久、很黄很 BL 的日更下去;

同时邀请大侠 关注、星标 算法金,围观日更万日,助你功力大增、笑傲江湖