大侠幸会,在下全网同名[算法金] 0 基础转 AI 上岸,多个算法赛 Top [日更万日,让更多人享受智能乐趣]

定义

特点

应用领域

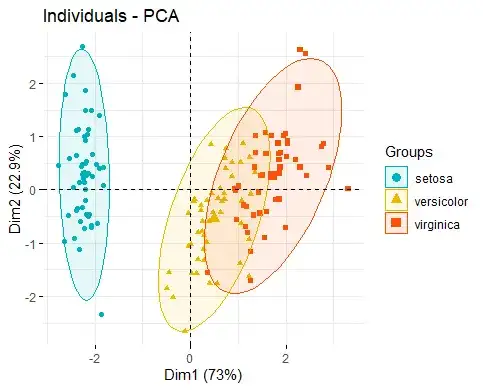

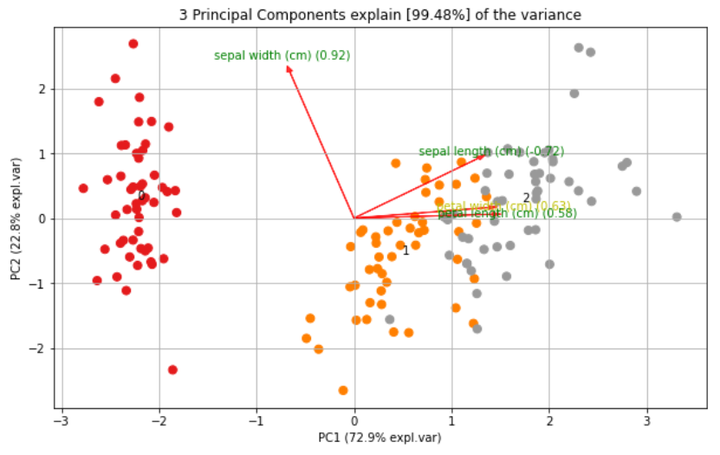

介绍一个用于主成分分析的 Python 库

PCA的核心是构建在sklearn功能之上,以便在与其他包结合时实现最大的兼容性。

除了常规的PCA外,它还可以执行SparsePCA和TruncatedSVD。

其他功能包括:

pip install pca复制

from pca import pca # 导入PCA模块

import numpy as np

import pandas as pd

# Dataset

from sklearn.datasets import load_iris # 导入鸢尾花数据集

# 从鸢尾花数据集中创建DataFrame对象

X = pd.DataFrame(data=load_iris().data, columns=load_iris().feature_names, index=load_iris().target)

# 初始化PCA模型,指定主成分数量为3,并进行数据标准化

model = pca(n_components=3, normalize=True)

# 拟合并转换数据

out = model.fit_transform(X)

# 创建只包含方向的图

fig, ax = model.biplot(textlabel=True, legend=False, figsize=(10, 6))

复制

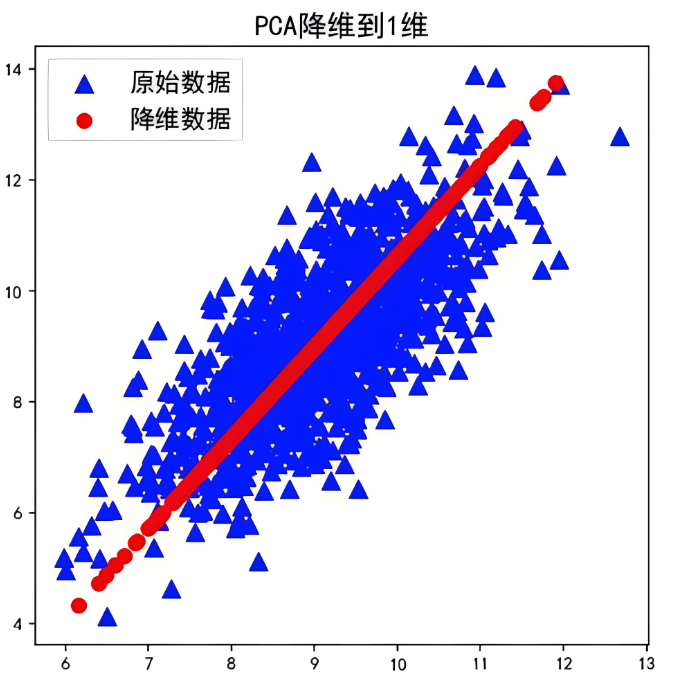

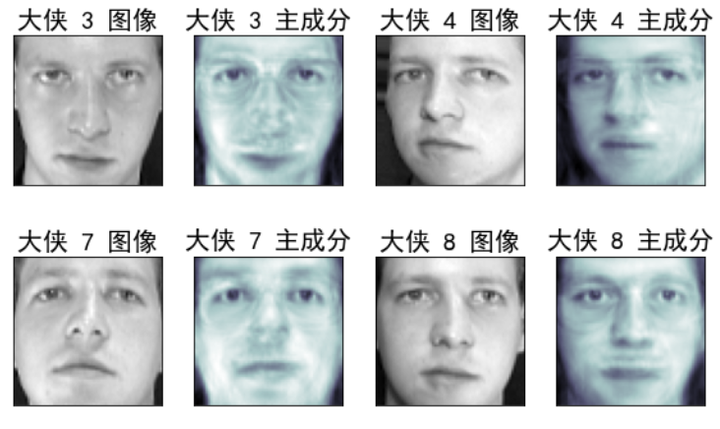

下面我们使用 sklearn 里面的 PCA 工具,在一组人脸数据上直观感受下,

# 导入必要的库

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import fetch_olivetti_faces

from sklearn.decomposition import PCA

# 加载Olivetti人脸数据集

faces_data = fetch_olivetti_faces()

X = faces_data.data

# 可视化原始图像和对应的主成分

n_images = 4 # 每行显示的图像数量

n_rows = 4 # 总共的行数

fig, axes = plt.subplots(n_rows, 2*n_images, figsize=(16, 10), subplot_kw={'xticks':[], 'yticks':[]})

# 使用PCA降维

n_components = 50 # 设置PCA保留的主成分数量

pca = PCA(n_components=n_components, whiten=True, random_state=42)

X_pca = pca.fit_transform(X)

for r in range(n_rows):

for i in range(n_images):

index = r * n_images + i

axes[r, 2*i].imshow(X[index].reshape(64, 64), cmap='gray')

axes[r, 2*i].set_title(f'大侠 {index+1} 图像', fontproperties='SimHei') # 手动设置字体

axes[r, 2*i+1].imshow(pca.inverse_transform(X_pca[index]).reshape(64, 64), cmap='bone')

axes[r, 2*i+1].set_title(f'大侠 {index+1} 主成分', fontproperties='SimHei') # 手动设置字体

plt.tight_layout()

plt.show()

复制我们保留了前 50 个主成分

通过可视化对比图直观感受下,信息保留了多多少,损失了多少

通过对比图可以看到,某一张人脸的基本信息都保留了下来

如果保留 前 100 个主成分,那就更接近原始图片了

你也可以试下,保留 1 个主成分会怎样?通过保留的信息你还认得出来哪过大侠是哪过吗

烦请大侠多多 分享、在看、点赞,助力算法金又猛又持久、很黄很 BL 的日更下去;我们一起,让更多人享受智能乐趣

同时邀请大侠 关注、星标 算法金,围观日更万日,助你功力大增、笑傲江湖