确认有无英伟达显卡,有才能安装GPU版的pytorch,否则只能装CPU版

1.任务管理器->性能:

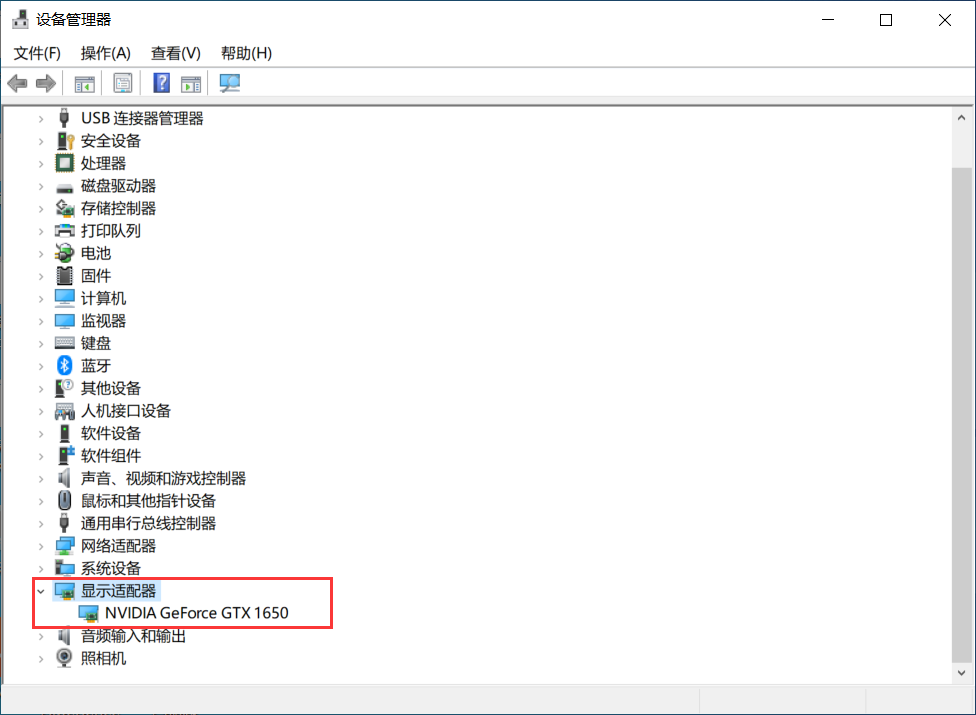

设备管理器->显示适配器,也可以:

nvidia驱动安装地址(大部分电脑自带,不需要额外安装):

https://www.nvidia.cn/Download/index.aspx?lang=cn

2.nvidia控制面板->帮助->系统信息->组件

查看nvidia驱动器版本,图中为11.7,即要安装的cuda版本不高于11.7即可

cmd/anaconda prompt也可:

nvidia-smi

这里nvcc -V一定是你电脑目前版本,nvidia-smi不一定

3.在官网找到自己对应的历史版本

https://developer.nvidia.com/cuda-toolkit-archive

选择一个版本下载

根据B站小土堆佬说,pytorch似乎已经集成了cudnn,不需要另外下载。

4.进入pytorch官网:https://pytorch.org/

这里版本都高于11.7,选择历史版本

5.在命令行安装

以下提供镜像源:

清华镜像源:https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/pytorch/win-64/

北京镜像源:https://mirrors.bfsu.edu.cn/anaconda/cloud/pytorch/win-64/

阿里镜像源:http://mirrors. aliyun.com/anaconda/cloud pytorch/win-64/

安装pytorch其实主要是安装torch、torchvision、torchaudio这三个包,torch最大一个多G,直接安装可能速度较慢

这一步另一个方法可以通过网址:https://download.pytorch.org/whl/torch/查找

ctrl+F搜索cu117,cu表示cuda,cp表示python,找到对应的链接,下载

下载完成后在命令行输入pip install 路径\文件名安装

如pip install E:\Anaconda\torch-1.13.1+cu117-cp37-cp37m-win_amd64.whl

6.查看

如果conda list中pytorch后面版本号带有cpu,那就是中间哪儿出错了,装的cpu版本,卸载重来。

命令行python->import torch->torch.cuda.is_available()

返回True即安装成功

over ^o^/

本文简单介绍了使用Python解决使用GPU的方法,并给出了TensorFlow和PyTorch示例;本文还介绍了TensorFlow GPU的安装版本介绍,以及介绍了安装CUDA的详细教程。