5月14日凌晨1点,OpenAI发布了名为GPT-4o 最新的大语言模型,再次引领了人工智能领域的又一创新浪潮,让整个行业都为之震动。

据OpenAI首席技术官穆里-穆拉提(Muri Murati)表示,GPT-4o是在继承GPT-4智能的基础上,对文本、视觉和音频功能进行了进一步改进,而且目前所有用户都能免费使用,但付费用户将享有更高的容量限制。

访问地址:https://openai.com/index/hello-gpt-4o/

如果你还不知道如何使用它,今天这篇文章来帮助你成功使用GPT4o。

其实很简单,你只需要直接登录官网https://chat.openai.com/打开OpenAI聊天网址,如果没有提示最新模型的话,你可以在网址后添加?model=gpt-4o,然后按回车进行强制切换。

https://chatgpt.com/?model=gpt-4o

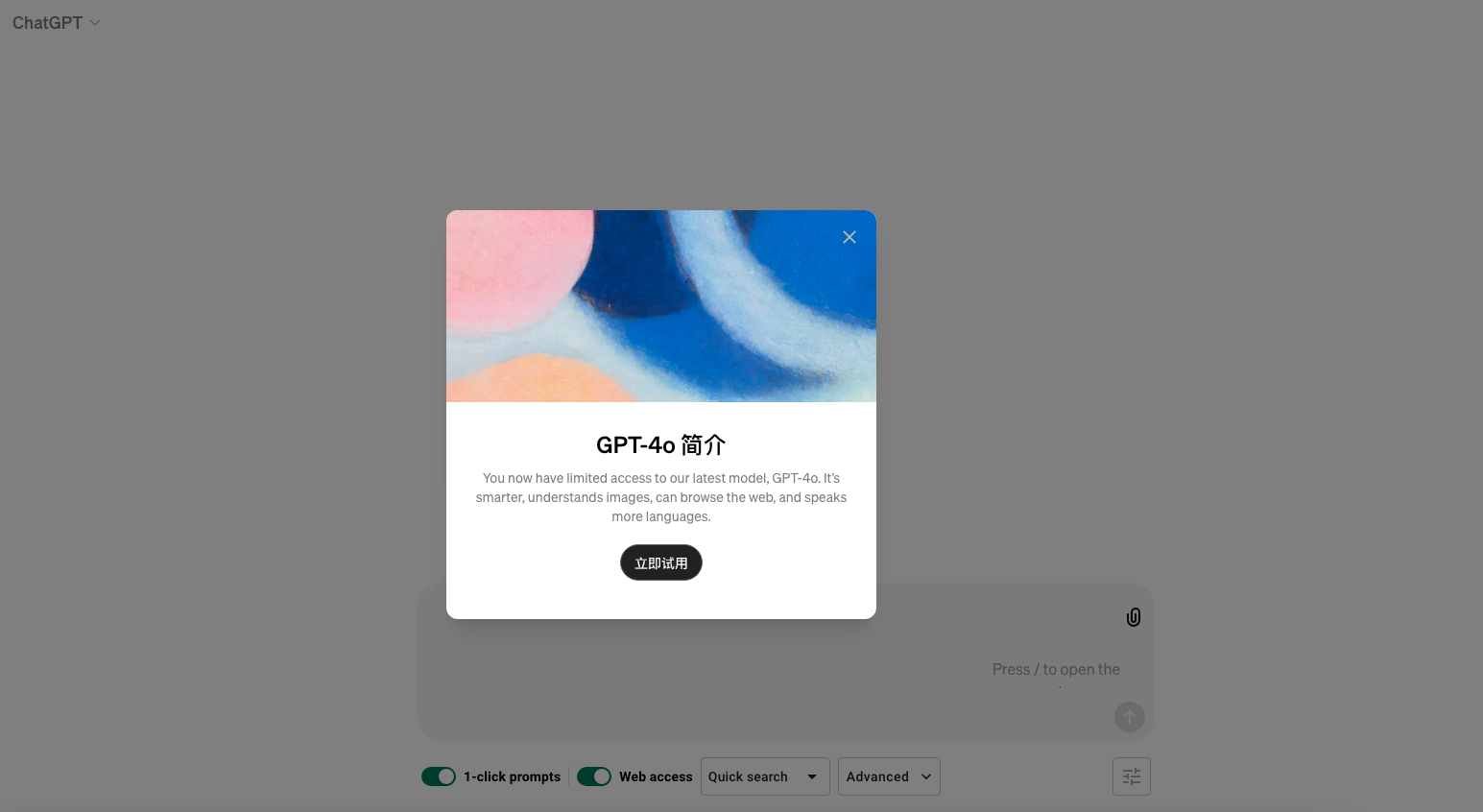

此时,你应该可以看到下述提示

如果此时模型选项从原本的GPT3.5变为ChatGPT,说明你就可以直接使用这个模型了。

你还可以在聊天窗口中选择更改模型进行确认GPT-4o是否生效

值得一提的是,GPT-4o可以接受任何形式的输入,包括文本、音频和图像,甚至是这些不同形式的组合。更为神奇的是,它还能根据这些输入,生成相应的文本、音频或图像作为输出。这种能力使得GPT-4成为了一个真正的多模态人工智能模型。

GPT-4o、GPT-3.5和GPT-4这三者之间的区别主要体现在功能、性能、模型规模以及输入输出能力等方面。

GPT-3.5:对GPT-3进行的改进和优化,主要侧重于文本输入输出能力。GPT-3.5可以更好地适应各种自然语言处理任务,并在语言生成、机器翻译、问答系统等方面。

GPT-4:GPT-4它比GPT-3.5拥有更多的参数,拥有数千亿个参数,具有更强大的语言理解和生成能力。支持多模态输入,能够处理文本、图像等多种数据类型,在理解复杂语言结构、上下文以及生成更连贯和准确的回答方面有显著提升。

GPT-4o:这是OpenAI在2024年5月14日推出的新模型,GPT-4o具有跨听、看、说三大领域的全能性输入输出能力,可以接受文本、音频和图像的组合输入,并生成任意组合的文本、音频和图像输出。它展现了一种全能性,可以接受文本、音频和图像的组合输入,并生成任意组合的文本、音频和图像输出。GPT-4o的“o”代表“omni”,意为“全能”。在官方演示视频中,GPT-4o能够在短时间内对音频输入做出反应,这与人类在对话中的反应时间相近。此外,GPT-4o还具有高效的图像和音频理解能力,以及多语言处理能力,能够处理50种不同的语言。

最后需要说明的是,目前三个版本:

目前,GPT-4o的文本和图像功能已经开始在ChatGPT中逐步推出,用户可以在ChatGPT平台上免费体验到GPT-4o的相关功能,但免费版有使用次数限制,Plus用户可以享受到5倍的调用额度。另外,GPT-4o、GPT-3.5和GPT-4在功能、性能、模型规模以及输入输出能力等方面各有特点和优势,用户可以根据自身需求选择适合的模型。