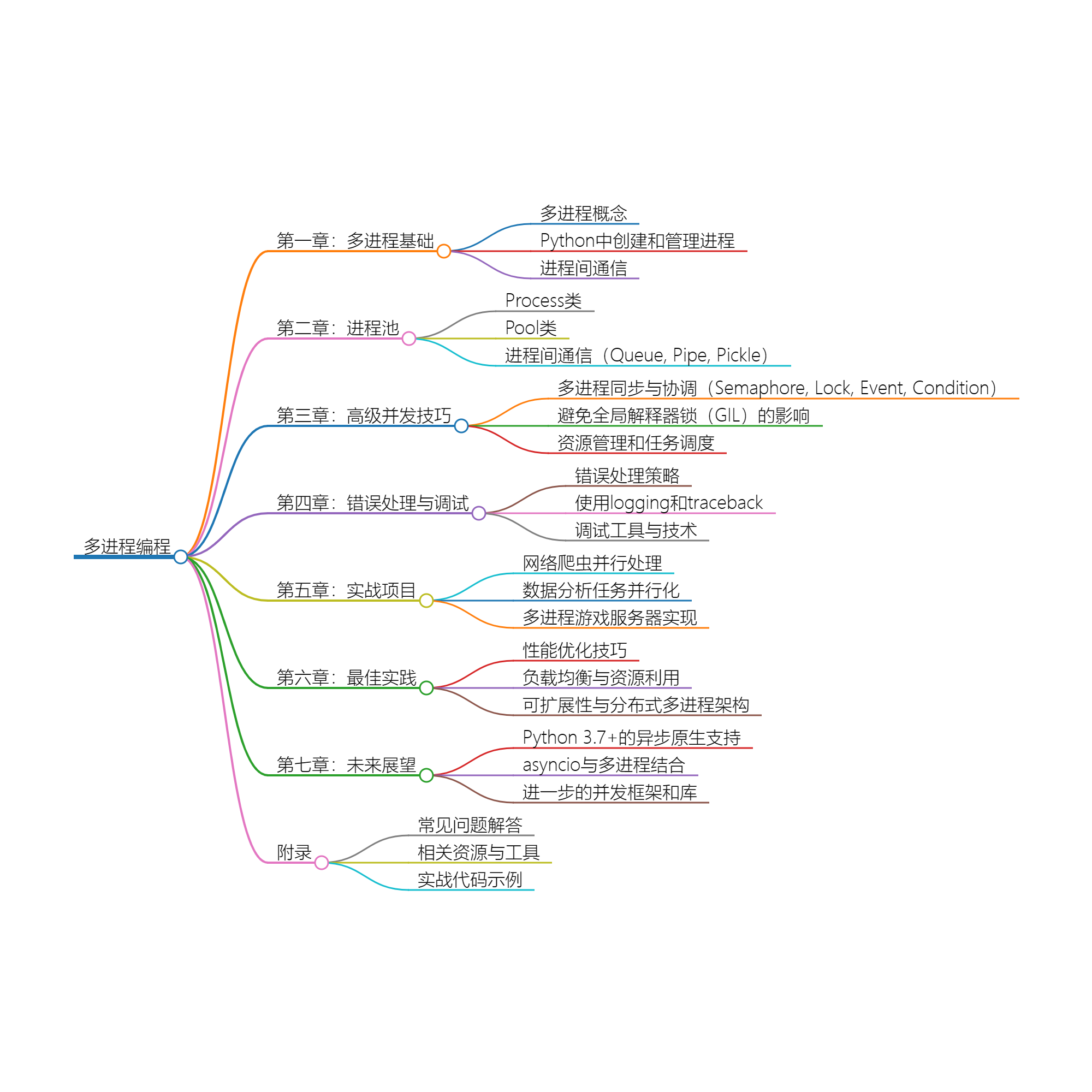

title: 深入理解Python多进程:从基础到实战

date: 2024/4/29 20:49:41

updated: 2024/4/29 20:49:41

categories:

tags:

在Python编程中,多进程是一种重要的并发编程方式,可以让我们充分利用多核处理器的计算能力,实现并行处理任务,提高程序的运行效率。与多线程相比,多进程具有独立的内存空间,避免了全局解释器锁(GIL)的影响,因此更适合于CPU密集型的任务。

在Python中,可以使用multiprocessing模块来创建和管理进程。通过Process类可以创建新的进程,通过Pool

类可以创建进程池,实现并行处理任务。多进程之间可以通过队列(Queue)、管道(Pipe)等方式进行通信,从而实现数据共享和协作。

总之,选择多进程可以让我们更好地利用计算资源,提高程序的运行效率,同时避免了一些多线程并发编程中的问题,是一种值得掌握的并发编程方式。

在Python中,可以使用multiprocessing模块来创建和管理进程。通过Process

类可以创建新的进程,实现并行处理任务。每个Python进程都有自己独立的解释器和内存空间,进程之间数据不共享,需要通过特定方式进行通信。

总之,线程适合处理需要频繁I/O操作的任务,进程适合处理需要大量计算的任务。在Python中,多线程受到全局解释器锁的限制,多进程能更好地利用多核处理器,选择合适的并发编程方式可以提高程序的运行效率。

multiprocessing是 Python 中用于支持多进程编程的内置模块,可以实现并行处理任务,充分利用多核处理器。multiprocessing.Process类用于创建新的进程。通过实例化Processstart()方法启动进程,调用join()方法等待进程结束。每个Processmultiprocessing.Pool类用于创建进程池,可以方便地管理多个进程。通过Pool类的map()、apply()multiprocessing.Queue类提供了进程间通信的队列。多个进程可以通过共享的队列进行数据交换,实现进程间的通信。队列是线程/进程安全的,可以在多个进程之间安全地传递数据。multiprocessing.PipePipe可以实现两个进程之间的通信。pickle模块用于序列化和反序列化 Python 对象,可以将对象转换为字节流进行传输。在进程间通信中,可以使用pickle通过使用multiprocessing模块提供的Process类、Pool类以及进程间通信的机制,可以方便地实现并行处理任务,并实现不同进程之间的数据交换和通信,从而提高程序的运行效率和灵活性。

multiprocessing.Pool的主要用法是通过apply()、map()、starmap()等方法将任务提交给进程池,然后通过Poolclose()和join()方法关闭和等待所有进程完成。例如:from multiprocessing import Pool

def worker(num):

# 进程中的工作

pass

with Pool(processes=4) as pool:

results = pool.map(worker, range(10))

优化:为了提高效率,可以考虑以下几点:

multiprocessing模块本身并不直接支持异步 I/O,因为 I/O 操作通常是阻塞的。然而,可以结合其他库(如asyncioconcurrent.futures)来实现异步 I/O。例如,concurrent.futures提供了ThreadPoolExecutor和ProcessPoolExecutorasyncio的run_in_executor()方法实现异步 I/O。concurrent.futures:from concurrent.futures import ThreadPoolExecutor, as_completed

def async_io_task(i):

# 异步 I/O 操作,如网络请求或文件读写

pass

with ThreadPoolExecutor() as executor:

futures = {executor.submit(async_io_task, i) for i in range(10)}

for future in as_completed(futures):

result = future.result()

# 处理结果

这里,ThreadPoolExecutor用于管理线程,as_completed()用于异步等待所有任务完成。这样,尽管 I/O 操作是异步的,但整个进程池的其他任务仍可以并行执行。

concurrent.futures提供了更简洁的接口,它抽象了底层的线程池或进程池,使得异步编程更加方便。ProcessPoolExecutor

和ThreadPoolExecutor是两个主要的类,它们都支持submit()方法提交任务,然后你可以通过as_completed()或result()

等方法获取结果。与multiprocessing.Pool相比,concurrent.futures更加面向异步编程,更适合现代 Python 应用。

这一章将深入探讨Python中进行多进程同步与协调的高级技巧,以及如何避免全局解释器锁(GIL)的影响,还有资源管理和任务调度。

import multiprocessing

semaphore = multiprocessing.Semaphore(2) # 允许两个进程同时访问资源

def worker(semaphore):

semaphore.acquire()

try:

# 执行任务

pass

finally:

semaphore.release()

import multiprocessing

lock = multiprocessing.Lock()

def worker(lock):

lock.acquire()

try:

# 执行任务

pass

finally:

lock.release()

import multiprocessing

event = multiprocessing.Event()

def setter(event):

event.set() # 设置事件

def waiter(event):

event.wait() # 等待事件被设置

import multiprocessing

condition = multiprocessing.Condition()

def worker_with_condition(condition):

with condition:

condition.wait() # 等待通知

# 执行任务

GIL是CPython中的一个机制,它确保同一时间只有一个线程在执行Python字节码。为了绕过GIL,可以使用以下方法:

with语句)确保资源如文件和网络连接被正确关闭。对于进程和线程,确保使用PoolExecutor的上下文管理器来关闭和等待所有任务完成。multiprocessing.Queue)来调度任务,其中生产者进程将任务放入队列,消费者进程从队列中取出任务并执行。import multiprocessing

def producer(queue):

# 生产任务

queue.put(task)

def consumer(queue):

while True:

task = queue.get()

# 处理任务

queue.task_done()

queue = multiprocessing.Queue()

producer_process = multiprocessing.Process(target=producer, args=(queue,))

consumer_process = multiprocessing.Process(target=consumer, args=(queue,))

producer_process.start()

consumer_process.start()

producer_process.join()

queue.join() # 等待队列中的所有任务被处理

通过这些高级技巧,你可以更有效地管理并发任务,提高应用程序的性能和稳定性。

在这一章中,我们将讨论进程间的错误处理与调试,包括错误处理策略、使用logging和traceback进行错误处理,以及调试工具与技术。

在多进程编程中,错误处理非常重要,因为一个进程的错误可能会影响其他进程甚至整个应用程序。以下是一些错误处理策略:

multiprocessing.Pool),要注意捕获并处理子进程中抛出的异常,以避免整个进程池被终止。import logging

logging.basicConfig(filename='example.log', level=logging.DEBUG)

logging.debug('This is a debug message')

logging.error('This is an error message')

import traceback

try:

# 可能会引发异常的代码

pass

except Exception as e:

traceback.print_exc()

import pdb

pdb.set_trace() # 设置断点

通过合理的错误处理策略、使用logging和traceback记录错误信息,以及灵活运用调试工具与技术,可以更好地处理进程间的错误和调试工作,提高程序的稳定性和可靠性。

在这一章中,我们将介绍三个常见的多进程应用场景,包括网络爬虫并行处理、数据分析任务并行化以及多进程游戏服务器实现。

在网络爬虫中,并行处理可以提高爬取速度和效率。可以使用多进程技术将爬取任务分配到多个进程中,并行爬取多个网页。

下面是一个简单的多进程网络爬虫示例:

import requests

from multiprocessing import Pool

# 定义爬取函数

def crawl(url):

response = requests.get(url)

return response.text

# 定义进程池

with Pool(processes=5) as pool:

# 定义要爬取的网页链接

urls = ['https://www.example.com/1', 'https://www.example.com/2', 'https://www.example.com/3']

# 使用进程池并行爬取网页

results = pool.map(crawl, urls)

# 输出结果

for result in results:

print(result)

在数据分析中,并行处理可以提高计算速度和效率,减少计算时间。可以使用多进程技术将数据分析任务分配到多个进程中,并行处理。

下面是一个简单的多进程数据分析示例:

import numpy as np

from multiprocessing import Pool

# 定义数据分析函数

def analyze(data):

return np.mean(data)

# 定义进程池

with Pool(processes=5) as pool:

# 定义要分析的数据集

data = np.random.rand(100000)

# 将数据集分成多个子集

sub_datas = [data[i::5] for i in range(5)]

# 使用进程池并行分析数据子集

results = pool.map(analyze, sub_datas)

# 输出结果

print(np.mean(results))

在游戏服务器中,多进程技术可以提高并发连接数和系统吞吐量,支持更多玩家在线并行游戏。

下面是一个简单的多进程游戏服务器示例:

from socket import *

from multiprocessing import Process

# 定义游戏服务器进程

def game_server(host, port):

# 创建TCP套接字

sock = socket(AF_INET, SOCK_STREAM)

sock.setsockopt(SOL_SOCKET, SO_REUSEADDR, 1)

sock.bind((host, port))

sock.listen(5)

while True:

# 等待客户端连接

conn, addr = sock.accept()

print('Connected by', addr)

# 创建子进程处理客户端连接

p = Process(target=handle_client, args=(conn,))

p.start()

# 定义客户端处理函数

def handle_client(conn):

while True:

try:

# 接收客户端数据

data = conn.recv(1024)

if not data:

break

# 处理客户端数据

data = data.decode('utf-8')

response = process_data(data)

# 发送处理结果

conn.send(response.encode('utf-8'))

except Exception as e:

print(e)

break

# 关闭连接

conn.close()

# 定义数据处理函数

def process_data(data):

# 处理数据...

return 'OK'

# 运行游戏服务器

if __name__ == '__main__':

game_server('0.0.0.0', 8000)

通过这些实战项目,我们可以看到多进程技术在实际应用中的重要性和威力,可以提高程序性能和效率,提供更好的用户体验和服务质量。

实践这些最佳实践可以确保并发应用程序在高负载下仍能保持高效和稳定。同时,持续监控和优化是保持性能的关键。

未来的并发编程将更加注重性能、可扩展性和灵活性,同时更多的工具和框架将会被开发出来,帮助开发者更好地应对复杂的并发编程需求。持续关注并发编程领域的发展,将有助于把握未来的趋势并提升自身技能。

import asyncio

async def download(url):

print(f'Downloading {url}')

await asyncio.sleep(1)

print(f'Downloaded {url}')

async def main():

coroutines = [download(url) for url in ['http://www.example.com', 'http://www.python.org']]

await asyncio.gather(*coroutines)

if __name__ == '__main__':

asyncio.run(main())

import asyncio

import multiprocessing

async def download(url):

print(f'Downloading {url}')

await asyncio.sleep(1)

print(f'Downloaded {url}')

def worker(url):

asyncio.run(download(url))

if __name__ == '__main__':

urls = ['http://www.example.com', 'http://www.python.org']

with multiprocessing.Pool(processes=2) as pool:

pool.map(worker, urls)

请注意,这些代码示例只是简单的实现,并未考虑完整的错误处理和资源管理。在实际应用中,需要根据具体场景和需求进行优化和扩展。

多进程是指在操作系统中同时运行多个独立的进程,每个进程有自己独立的内存空间和资源。多进程可以实现并发处理,提高程序的性能和效率。

在Python中可以使用multiprocessing模块创建多进程。通过multiprocessing模块提供的Process类可以创建子进程,从而实现多进程编程。

多进程是在不同的进程中执行任务,每个进程有独立的内存空间;而多线程是在同一个进程中创建多个线程,共享进程的内存空间。多进程更安全稳定,但开销较大;多线程更高效,但需要注意线程安全。

在多进程中可以使用multiprocessing模块提供的Queue、Pipe、Manager等机制实现进程间通信。这些机制可以在多个进程之间传递数据和共享资源。

在多进程中,每个进程都有自己的异常处理,可以使用try-except语句捕获异常并处理。此外,可以使用进程间通信机制将异常信息传递给父进程进行处理。

为了避免资源竞争和死锁,可以使用进程间通信机制进行资源共享,并且在设计多进程程序时合理规划资源的使用顺序和互斥访问。

可以使用进程池(Pool)来控制多进程的数量,通过设置最大进程数量来限制同时运行的进程数量,从而避免资源过度消耗和系统负载过高。

在多进程中,可以使用join()方法来等待子进程结束,并获取子进程的返回值。也可以通过进程间通信机制将子进程的返回值传递给父进程。

在多进程中可以使用共享内存、Manager、Pipe等机制来实现数据共享。需要注意多进程之间的数据同步和互斥访问,避免数据不一致和竞争条件。

可以使用队列、事件、信号等机制在多进程之间实现任务调度和协同工作。通过合理设计进程之间的通信和同步机制,可以实现多进程之间的协同工作。

在Python中,由于全局解释器锁(GIL)的存在,多线程在执行CPU密集型任务时可能不会提供真正的并行执行。特别是在Windows上,由于GIL和线程调度的问题,多线程的性能可能不如多进程。多进程可以绕过GIL的限制,因为每个进程有自己的Python解释器和GIL。

可以使用multiprocessing.Event来通知所有进程应该终止。当主进程决定终止所有子进程时,它可以设置这个事件,而子进程可以检查这个事件并在适当的时候退出。

from multiprocessing import Process, Event

def worker(stop_event):

while not stop_event.is_set():

print("Doing work")

# Do some work here

print("Exiting")

if __name__ == "__main__":

stop_event = Event()

p = Process(target=worker, args=(stop_event,))

p.start()

# Do other things

stop_event.set() # Signal the process to terminate

p.join() # Wait for the process to exit

在某些操作系统(如Windows)上,直接使用fork()来创建子进程是不可能的。Python的multiprocessing

模块会自动处理这种情况,但是如果你直接使用了底层的系统调用,可能会遇到问题。为了避免这种错误,应该始终使用multiprocessing

模块提供的API来创建和管理进程。

在多进程中,每个进程都会产生自己的日志输出,这可能会导致日志记录混乱。为了避免这个问题,可以使用以下方法:

multiprocessing模块中的日志记录工具,如logging.Handler的子类,它们可以安全地在多进程环境中使用。如果需要确保进程按照特定的顺序启动,可以使用multiprocessing.Barrier或者条件变量(multiprocessing.Condition

)。这些同步原语可以帮助你控制进程的启动和执行顺序。

在部署多进程程序时,需要注意以下几点:

在 Python 3.4 Python 引入了一个非常有用的特性——协程,在本篇文章当中我们将详细介绍一下 Python 协程的原理以及虚拟机具体的实现协程的方式。

super 是 Python 面向对象编程当中非常重要的一部分内容,在本篇文章当中详细介绍了 super 内部的工作原理和 CPython 内部部分源代码分析了 super 的具体实现。

在本篇文章当中主要分析的生成器内部实现原理和相关的两个重要的字节码,分析了生成器能够停下来还能够恢复执行的原因,深入剖析的生成器的原理的各个细节。