本文介绍基于Python中ArcPy模块,对大量栅格遥感影像文件进行批量掩膜与批量重采样的操作。

首先,我们来明确一下本文的具体需求。现有一个存储有大量.tif格式遥感影像的文件夹;且其中除了.tif格式的遥感影像文件外,还具有其它格式的文件。

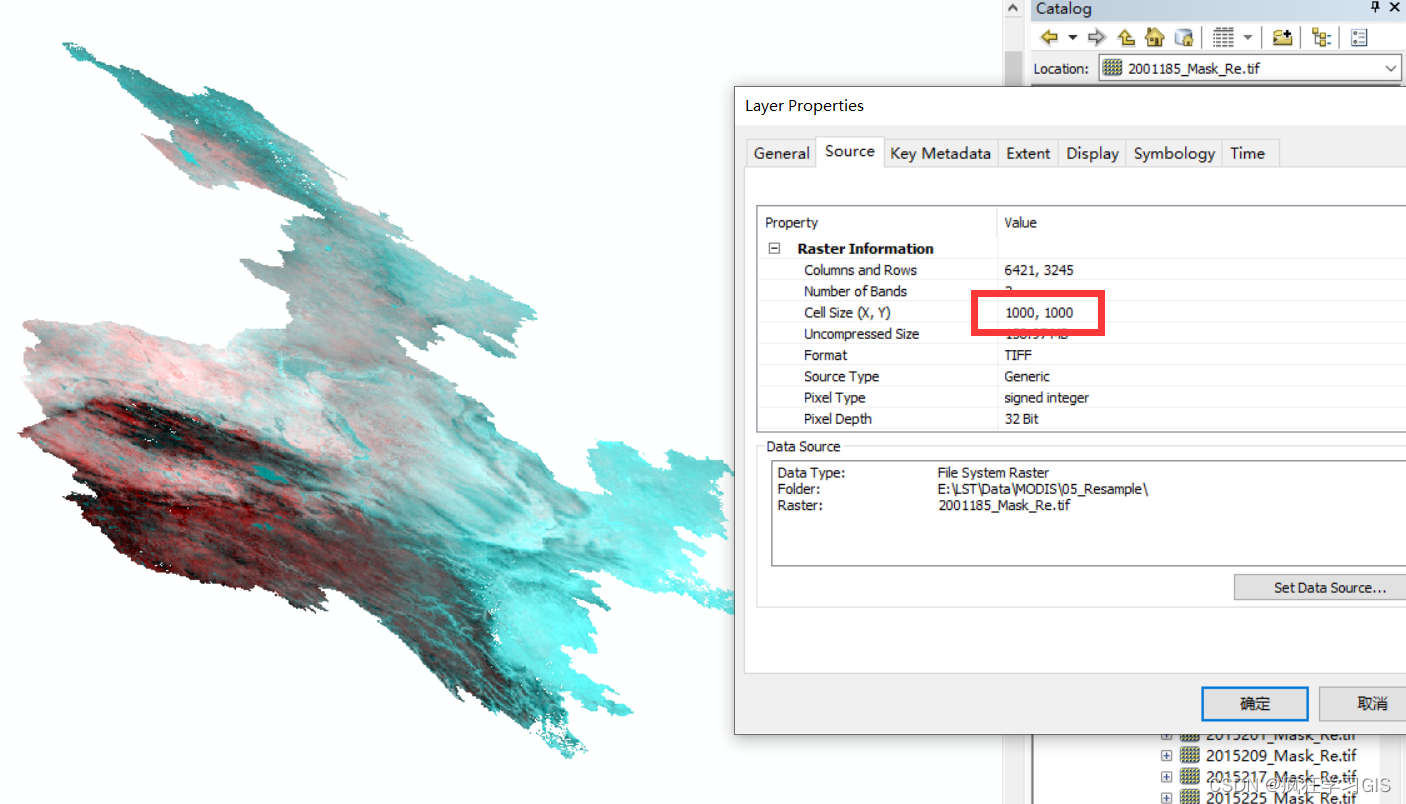

我们希望,依据一个已知的面要素矢量图层文件,对上述文件夹中的全部.tif格式遥感影像进行掩膜,并对掩膜后的遥感影像文件再分别加以批量重采样,使得其空间分辨率为1000 m。

明确了需求后,我们就可以开始具体的操作。首先,本文所需用到的代码如下。

# -*- coding: utf-8 -*-

"""

Created on Fri Apr 15 16:44:26 2022

@author: fkxxgis

"""

import arcpy

from arcpy.sa import *

tif_file_path="E:/LST/Data/NDVI/03_Mosaic/"

shp_file="E:/LST/Data/Region/YellowRiver_nineprovince.shp"

out_file_path="E:/LST/Data/NDVI/04_Mask/"

resample_file_path="E:/LST/Data/NDVI/05_Resample/"

arcpy.env.workspace=tif_file_path

arcpy.env.extent=shp_file

tif_file_name=arcpy.ListRasters("*","tif")

for tif_file in tif_file_name:

mask_result=ExtractByMask(tif_file,shp_file)

mask_result_path=out_file_path+"/"+tif_file.strip(".tif")+"_Mask.tif"

mask_result.save(mask_result_path)

arcpy.env.workspace=out_file_path

tif_file_name=arcpy.ListRasters("*","tif")

for tif_file in tif_file_name:

resample_file_name=tif_file.strip(".tif")+"_Re.tif"

arcpy.Resample_management(tif_file,resample_file_path+resample_file_name,

1000,"BILINEAR")

复制 其中,tif_file_path是原有掩膜前遥感图像的保存路径,shp_file是已知面要素矢量图层文件的保存路径,out_file_path是我们新生成的掩膜后遥感影像的保存路径,resample_file_path则是最终重采样后遥感影像的保存路径。

在这里,我们首先利用arcpy.ListRasters()函数,获取路径下原有的全部.tif格式的图像文件,并存放于tif_file_name中;随后,遍历tif_file_path路径下全部.tif格式图像文件(即遍历tif_file_name),并利用ExtractByMask()函数进行掩膜操作;其次,对于掩膜好的图层,在其原有文件名后添加"_Mask.tif"后缀,作为新文件的文件名。

对全部图像文件完成掩膜操作后,我们继续进行重采样操作。和前述代码思路类似,我们依然还是先遍历文件,并在其原有文件名后添加"_Re.tif"后缀,作为新文件的文件名;随后,利用Resample_management()函数进行重采样。其中,1000表示重采样的空间分辨率,在这里单位为米;"BILINEAR"表示用双线性插值的方法完成重采样。

以上便是本次操作的全部代码;我们这里选择在 IDLE (Python GUI) 中运行代码。运行完毕,得到的一个结果文件如下图;可以看到,遥感影像已经完成了掩膜,且空间分辨率已经为1000 m。

至此,大功告成。