摘要: 介绍SR-IOV 的概念、使用场景、VMware 和 KVM 中的配置方法。

第四部分:Intel网卡在VMware 环境 实现 SR-IOV 需要的条件和配置方法

第五部分:SR-IOV 在Red Hat Virtualization 的配制方法

第一部分:虚拟化通信延迟:

生产业务中,我们在虚拟化平台中遇到了部分虚拟机在业务高峰的时候,出现高延迟的情况。排查问题的时候,确认了两种情况,

- 是Hypervisor 的延迟是正常的;

- 是GuestOS 内部的延迟也是正常的;

所以判断应该是Hypervisor和GuestOS 之间的通信出现了问题。这时候想到了SR-IOV,想看看SR-IOV 能不能提供低延迟提供给对延迟敏感的业务。

写这篇文章之前,正好看到Red Hat 发布了 Red Hat Virtualization V4版,官方文档中,专门有一篇《Hardware considerations for implementing SR-IOV with Red Hat Virtualization》。

文章很短,主要介绍Red Hat Virtualization 中使用SR-IOV的前提条件:

- CPU 必须支持IOMMU(input/output memory management unit 输入输出内存管理单元)(比如英特尔的 VT-d 或者AMD的 AMD-Vi,Power8 处理器默认支持IOMMU)

- 固件Firmware 必须支持IOMMU

- CPU 根桥必须支持 ACS 或者ACS等价特性

- PCIe 设备必须支持ACS 或者ACS等价特性

- 建议根桥和PCIe 设备中间的所有PCIe 交换设备都支持ACS,如果某个PCIe交换设备不支持ACS,其后的所有PCIe设备只能共享某个IOMMU 组,所以只能分配给1台虚机。

Red Hat 虚拟化平台V4 先介绍到这里。

第二部分:IO 虚拟化

现在介绍一下 IO 虚拟化。IO 虚拟化目前主要也是分为3种,

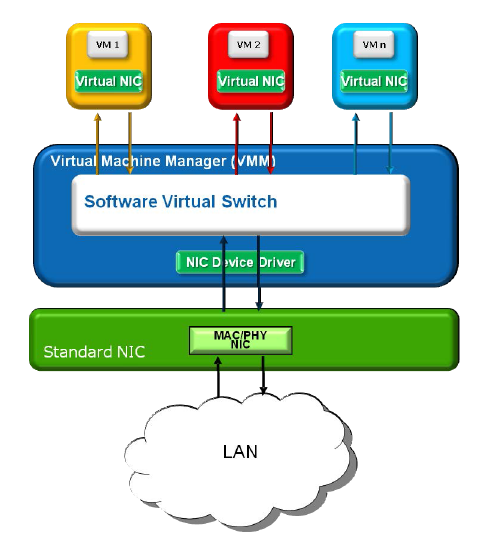

第一是全虚拟化:

通过VMM来模拟IO设备实现,VMM截获GuestOS的IO请求,通过软件模拟真实的硬件。

VMM必须处理所有虚机的IO请求,然后将所有的IO情况序列化为可以被底层硬件处理的单一IO流。

好处是GuestOS不需要考虑硬件设备的情况。问题是效率相对较低。例如 qemu。

第二种是IO半虚拟化技术:

通过前端和后端模拟实现虚拟化。GuestOS中的半虚拟化驱动为前端,VMM 提供的与GuestOS 通讯的驱动程序为后端。

前端驱动将GuestOS的请求通过与VMM之间的特殊通信机制发生给VMM后端需求,后端驱动处理完IO请求之后再发送给物理驱动。全虚拟化为了完成一次操作要涉及到多个寄存器的操作,使得VMM要截获每个寄存器访问并进行相应的模拟,就会导致多次上下文切换。这种方式能很大程度的减少上下文切换的频率,提供更大的优化空间。例如 virtio

软件的共享IO虚拟化技术

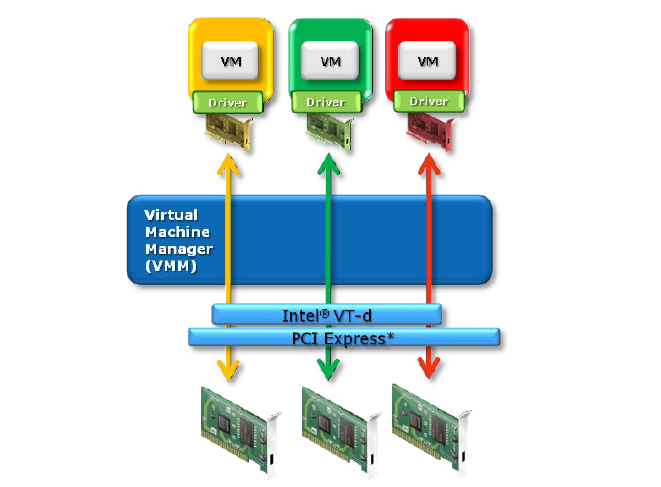

第三种是硬件辅助的IO虚拟化:

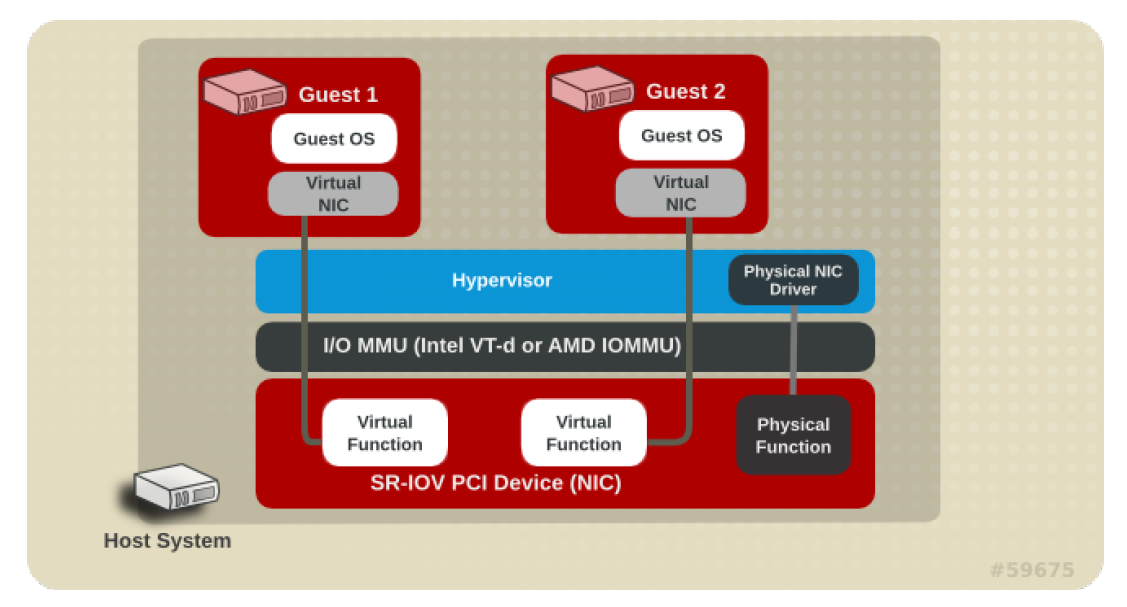

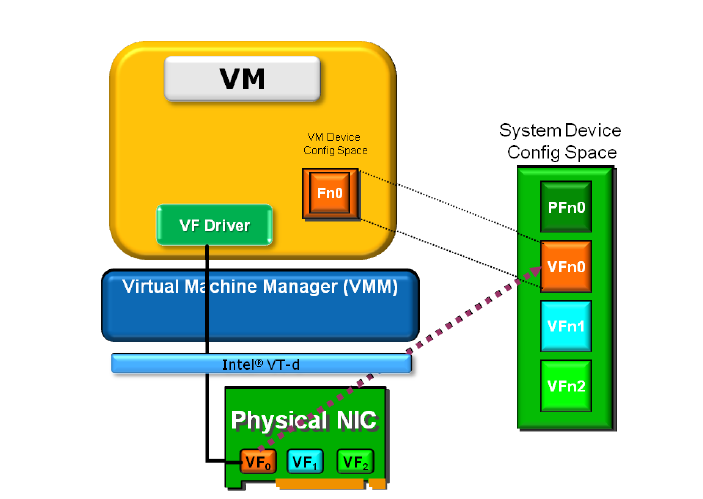

主要包括 英特尔VT-d, AMD的IOMMU(AMD-Vi) 和PCI-SIG 的IOV 。 前两种属于Directed I/O。物理设备直接分配给虚拟机使用,通过硬件芯片完成GPA到MA 的翻译。IOV 通过在硬件设备中增加一个PCIe 设备,用于呈现一个PF或多个VF,从而可以将每个VF单独分配给不同的虚机使用。

Intel VT-d

SR-IOV

第三部分:SR-IOV

SR-IOV(Single Root I/O Virtualization,单根I/O虚拟化)可允许Windows操作系统和微软的 Hyper-V 或 VMware 的 ESXi 等 hypervisor 对服务器的磁盘I/O设备,如现在 SR-IOV 对网卡设备一样进行封装,管理甚至共享。

- SR-IOV 技术是一种基于硬件的虚拟化解决方案,可提高性能和可伸缩性。

- SR-IOV 标准允许在虚拟机之间高效共享 PCIe(Peripheral Component Interconnect Express,快速外设组件互连)设备,并且它是在硬件中实现的,可以获得能够与本机性能媲美的 I/O 性能。

- SR-IOV 规范定义了新的标准,根据该标准,创建的新设备可允许将虚拟机直接连接到 I/O 设备。

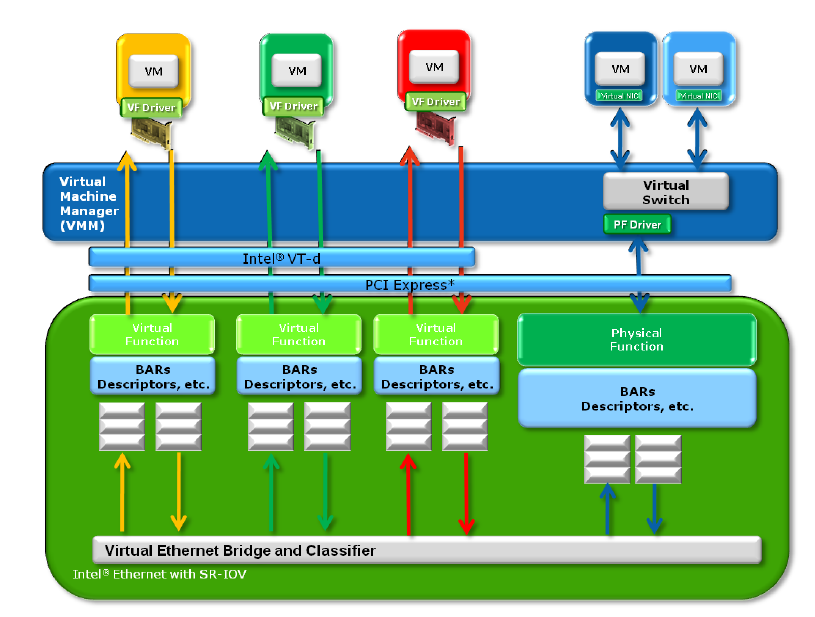

- SR-IOV 是 PCI-SIG 的一个IOV的规范,目的是提供一种标准规范,通过为虚拟机提供独立的内存空间、中断、DMA流,来绕过VMM实现数据移动。

SR-IOV 的优点

SR-IOV 标准允许在 IO 来宾域之间高效共享 PCIe 设备。

SR-IOV 设备可以具有数百个与某个物理功能 (Physical Function, PF) 关联的虚拟功能 (Virtual Function, VF)。

VF 的创建可由 PF 通过设计用来开启 SR-IOV 功能的寄存器以动态方式进行控制。

缺省情况下,SR-IOV 功能处于禁用状态,PF 充当传统 PCIe 设备。

具有 SR-IOV 功能的设备可以利用以下优点:

-

性能-从虚拟机环境直接访问硬件。

-

成本降低-节省的资本和运营开销包括:

-

节能

-

减少了适配器数量

-

简化了布线

-

减少了交换机端口

-

- SR-IOV 架构被设计用于将单个设备通过支持多个VF,并减少硬件的开销。

单个 I/O 资源可由许多虚拟机共享。共享的设备将提供专用的资源,并且还使用共享的通用资源。这样,每个虚拟机都可访问唯一的资源。因此,启用了 SR-IOV 并且具有适当的硬件和 OS 支持的 PCIe 设备(例如以太网端口)可以显示为多个单独的物理设备,每个都具有自己的 PCIe 配置空间。

SR-IOV 引入了两种功能类型:

1. 物理功能 (Physical Function, PF)

用于支持 SR-IOV 功能的 PCI 功能,如 SR-IOV 规范中定义。PF 包含 SR-IOV 功能结构,用于管理 SR-IOV 功能。PF 是全功能的 PCIe 功能,可以像其他任何 PCIe 设备一样进行发现、管理和处理。PF 拥有完全配置资源,可以用于配置或控制 PCIe 设备。

2. 虚拟功能 (Virtual Function, VF)

与物理功能关联的一种功能。VF 是一种轻量级 PCIe 功能,可以与物理功能以及与同一物理功能关联的其他 VF 共享一个或多个物理资源。VF 仅允许拥有用于其自身行为的配置资源。

注:部分图片源自 《PCI-SIG SR-IOV Primer》

第四部分:Intel网卡在VMware 环境 实现 SR-IOV 需要的条件和配置方法

1. 硬件需求:

- 兼容ESXi版本;

- 支持IOMMU,并且在BIOS中已开启;

- 支持VT-d 和 SR-IOV 规范;

- 在BIOS中开启SR-IOV;

2. 软件需求:

- ESXi 5.1 及以上版本;

- Red Hat Enterprise Linux 6.x 及以上版本;

- Windows Server 2008 R2 with SP2 及以上版本;

- VF 驱动必须兼容,并且支持 GuestOS 。

配置方法:

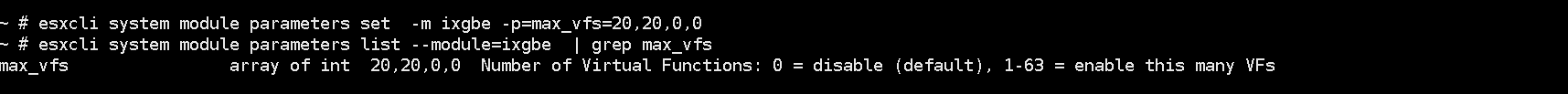

1) 创建VF

开启SSH, 登录ESXi , 使用以下命令创建VF

esxcli system module parameters set -m ixgbe -p=max_vfs=20,20,0,0esxcli system module parameters list --module=ixgbe | grep max_vfs复制esxcfg-module -g ixgb复制配置完成之后,重启ESXi,参看以及创建的VF

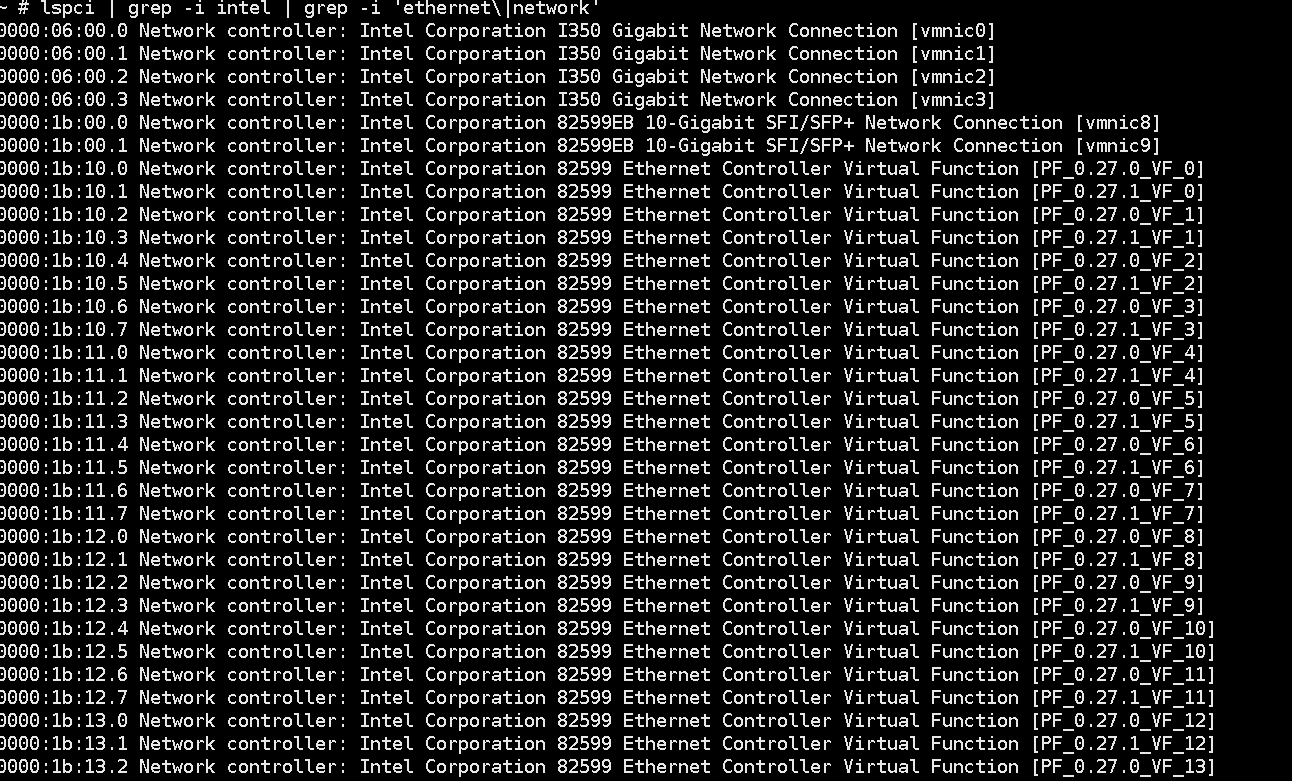

lspci | grep -i intel | grep -i 'ethernet\|network'

复制

补充一下,这一步可以通过Host Profile 尽快批量配置。

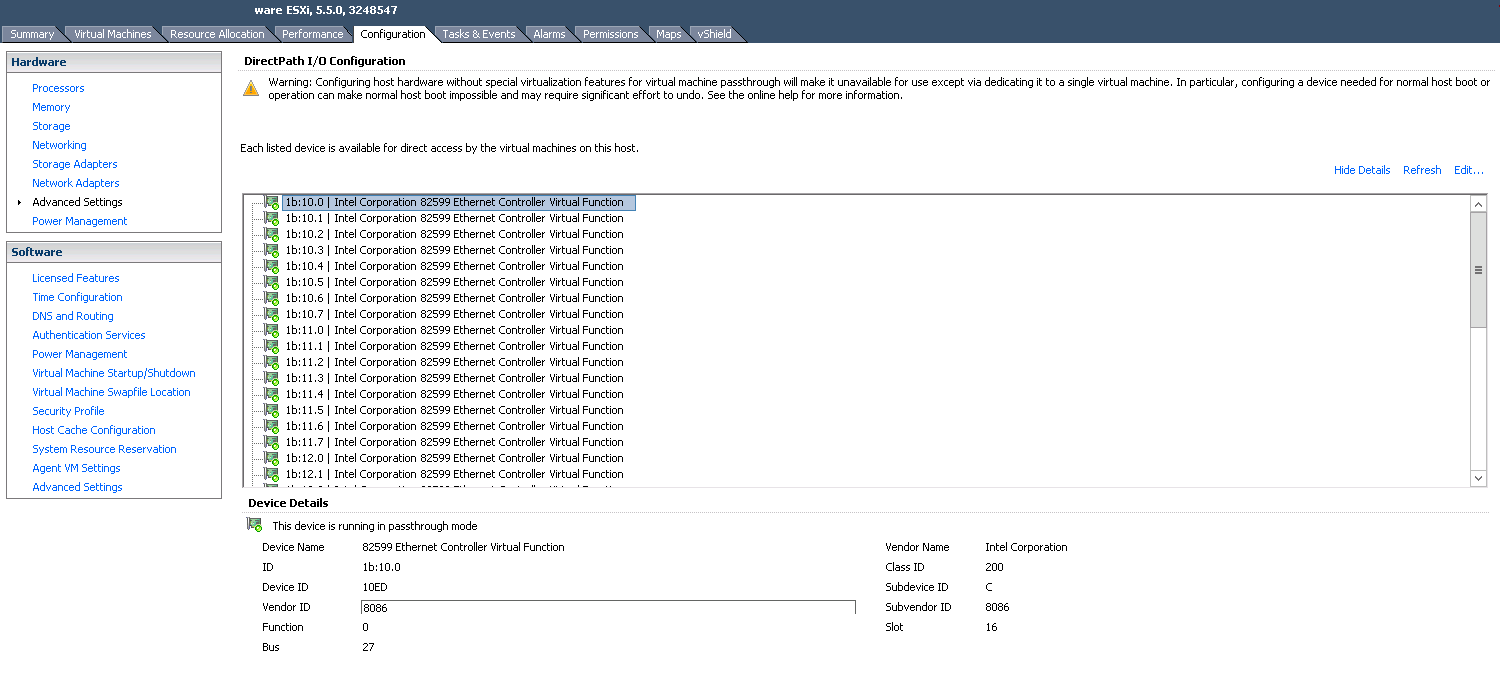

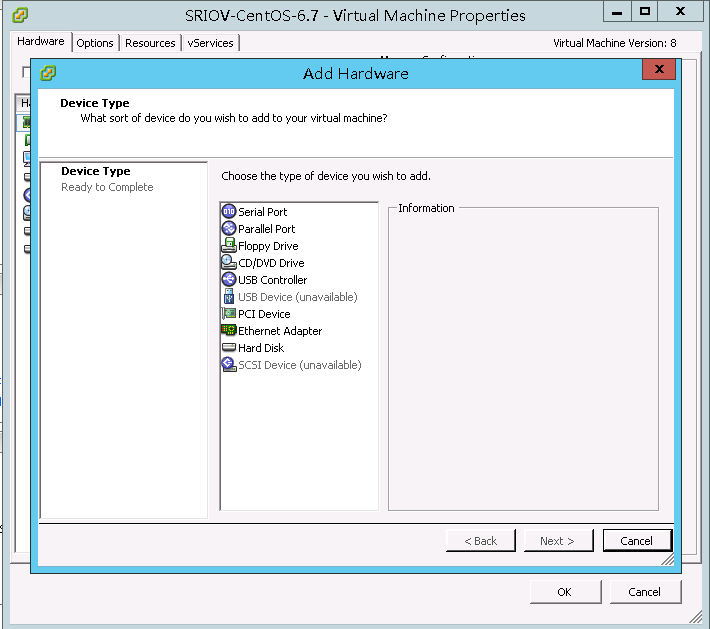

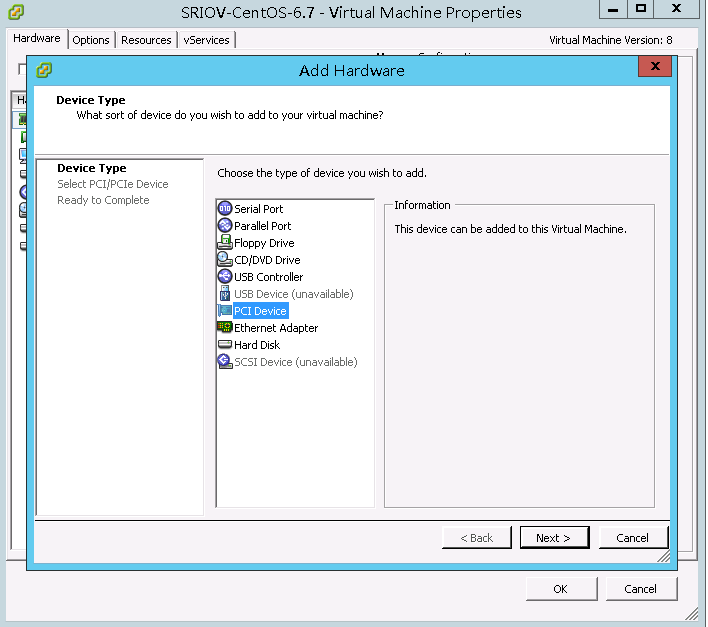

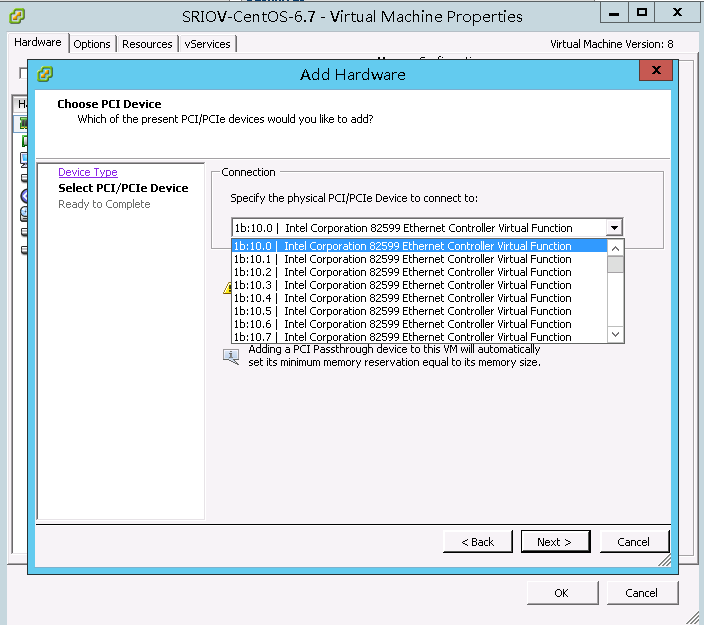

2)将VF分配给虚机

编辑虚机,添加PCI设备

选择VF,确定。

完成VF的分配。

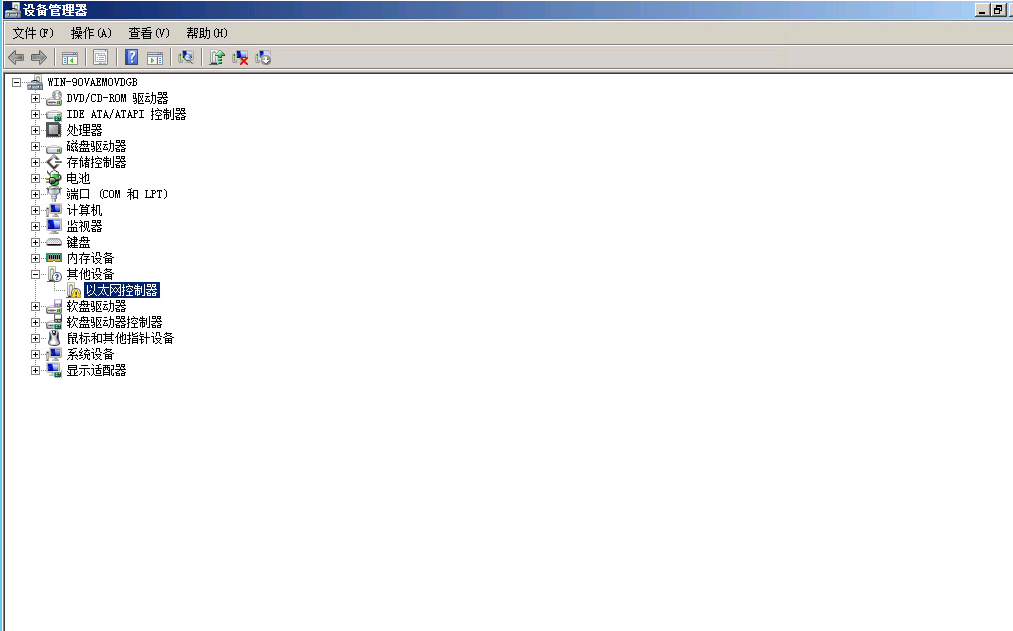

3)GuestOS 安装VF 驱动。

Windos 需要单独去下载VF驱动, CentOS 6.x 自带了igbx 的驱动。

第五部分:SR-IOV 在Red Hat Virtualization 的配制方法

1) 创建VF

首先通过lscpi 验证物理网卡,通过重新加载内核模块参数,来创建VF:

或者在rc.local 中配置:

echo 2 > /sys/class/net/enp14s0f0/device/sriov_numvfs

复制查看创建的VF

lscpi | grep 82587 virsh nodedev-list | grep 0b复制2) 将VF分配给虚机

virsh nodedev-dumpxml pci_0000_0b_00_0 >> /tmp/new-i nterface. xmlvirsh attach-device MyGuest /tmp/new-i nterface. xml --live --config复制后面的步骤相同,不再赘述。SR-IOV 今天就介绍到这里。如果大家有兴趣,推荐阅读以下内容:

《IBM Power Systems SR-IOV Technical Overview and Introduction》

《How to Configure Intel Ethernet Converged Network Adapter-Enabled VF on VMware ESXi 5.1》

《Implementing SR-IOV on HPE ProLiant Servers with VMware vSphere 5.1》

《Red_Hat_Enterprise_Linux-7-Virtualization_Deployment_and_Administration_Guide-en-US》

</article>复制