https://www.unicaca.com/info/detail/194.html复制

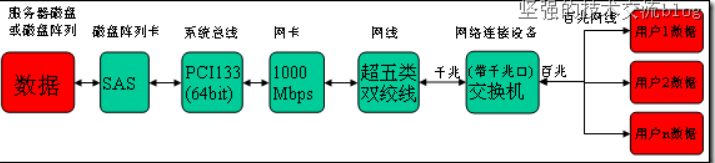

存放在服务器磁盘阵列的数据,响应用户的数据请求,从磁盘阵列读取到磁盘阵列卡,然后数据从磁盘阵列卡通过系统总线传输到网卡(当然途中会经过内存,只是内存的带宽远比磁盘阵列卡的大),从网卡传输到传输介质,再从传输介质到网络连接设备,最后从网络连接设备进行分流传入众用户。而用户存放数据到服务器,这个流程只要逆向就可。(带宽:带子的宽度,带子越宽,速度越快,汗!带宽指通道的最大数据传输能力。)

在这个流程中的各类硬件设备,根据情况可有多种选择。

典型上,我们最常用设备的数据传输流程图如下:

在这个传输流程中,服务器端,使用磁盘阵列就可以提高数据的吞吐量,根据需要可增加磁盘数量来提高数据的吞吐量,这个环节瓶颈不大,一般单块SAS硬盘实际平均读写速率可达到100MB/s,8块RAID0阵列,速度差不多能达到800MB/s;从阵列卡到系统总线,一般阵列卡如SAS用的是PCI-X,133MHz,64bit,那它的带宽=64/8*133*1000*1000/1024/1024=1014.7MB/s,这个阵列卡的带宽完全能胜任,那阵列卡的吞吐量与IOPS到底有是没用呢,下面由小编来介绍一下。

阵列卡的吞吐量与IOPS

阵列的瓶颈主要体现在2个方面,吞吐量与IOPS。

1、吞吐量

吞吐量主要取决于阵列的构架,光纤通道的大小(现在阵列一般都是光纤阵列,至于SCSI这样的SSA阵列,我们不讨论)以及硬盘的个数。阵列的构架与每个阵列不同而不同,他们也都存在内部带宽(类似于pc的系统总线),不过一般情况下,内部带宽都设计的很充足,不是瓶颈的所在。

光纤通道的影响还是比较大的,如数据仓库环境中,对数据的流量要求很大,而一块2Gb的光纤卡,所能支撑的最大流量应当是2Gb/8(小B)=250MB/s(大B)的实际流量,当4块光纤卡才能达到1GB/s的实际流量,所以数据仓库环境可以考虑换4Gb的光纤卡。

最后说一下硬盘的限制,这里是最重要的,当前面的瓶颈不再存在的时候,就要看硬盘的个数了,我下面列一下不同的硬盘所能支撑的流量大小:

10K rpm 15K rpm ATA

——— ——— ———

10M/s 13M/s 8M/s复制

那么,假定一个阵列有120块15K rpm的光纤硬盘,那么硬盘上最大的可以支撑的流量为120*13=1560MB/s,如果是2Gb的光纤卡,可能需要6块才能够,而4Gb的光纤卡,3-4块就够了。

2、IOPS

决定IOPS的主要取决与阵列的算法,cache命中率,以及磁盘个数。阵列的算法因为不同的阵列不同而不同,如我们最近遇到在hds usp上面,可能因为ldev(lun)存在队列或者资源限制,而单个ldev的iops就上不去,所以,在使用这个存储之前,有必要了解这个存储的一些算法规则与限制。

cache的命中率取决于数据的分布,cache size的大小,数据访问的规则,以及cache的算法,如果完整的讨论下来,这里将变得很复杂,可以有一天好讨论了。我这里只强调一个cache的命中率,如果一个阵列,读cache的命中率越高越好,一般表示它可以支持更多的IOPS,为什么这么说呢?这个就与我们下面要讨论的硬盘IOPS有关系了。

硬盘的限制,每个物理硬盘能处理的IOPS是有限制的,如

10K rpm 15K rpm ATA

——— ——— ———

100 150 50复制

同样,如果一个阵列有120块15K rpm的光纤硬盘,那么,它能撑的最大IOPS为120*150=18000,这个为硬件限制的理论值,如果超过这个值,硬盘的响应可能会变的非常缓慢而不能正常提供业务。

另外,我们上一篇也讨论了,在raid5与raid10上,读iops没有差别,但是,相同的业务写iops,最终落在磁盘上的iops是有差别的,而我们评估的却正是磁盘的IOPS,如果达到了磁盘的限制,性能肯定是上不去了。

那我们假定一个case,业务的iops是10000,读cache命中率是30%,读iops为60%,写iops为40%,磁盘个数为120,那么分别计算在raid5与raid10的情况下,每个磁盘的iops为多少。

raid5:

单块盘的

iops = (10000*(1-0.3)*0.6 + 4 * (10000*0.4))/120

= (4200 + 16000)/120

= 168

这里的10000*(1-0.3)*0.6表示是读的iops,比例是0.6,除掉cache命中,实际只有4200个iops而4 * (10000*0.4) 表示写的iops,因为每一个写,在raid5中,实际发生了4个io,所以写的iops为16000个

为了考虑raid5在写操作的时候,那2个读操作也可能发生命中,所以更精确的计算为:

单块盘的

iops = (10000*(1-0.3)*0.6 + 2 * (10000*0.4)*(1-0.3) + 2 * (10000*0.4))/120

= (4200 + 5600 + 8000)/120

= 148

计算出来单个盘的iops为148个,基本达到磁盘极限

raid10:

单块盘的

iops = (10000*(1-0.3)*0.6 + 2 * (10000*0.4))/120

= (4200 + 8000)/120

= 102

可以看到,因为raid10对于一个写操作,只发生2次io,所以,同样的压力,同样的磁盘,每个盘的iops只有102个,还远远低于磁盘的极限iops。

在一个实际的case中,一个恢复压力很大的standby(这里主要是写,而且是小io的写),采用了raid5的方案,发现性能很差,通过分析,每个磁盘的iops在高峰时期,快达到200了,导致响应速度巨慢无比。后来改造成raid10,就避免了这个性能问题,每个磁盘的iops降到100左右。

有需要了解更多信息的可查询CEACENT--嘉华众力官网;需要合作与咨询搭建方案请联系官网上的在线客服,嘉华众力自2000年成立以来一直在网络存储、传输这方面积累、沉淀;经过多年发展与全新的品牌定位,( CEACENT )嘉华众力品牌已成为国内外极具实力的数据通讯产品及方案提供商。