https://zhuanlan.zhihu.com/p/57704357复制

Prometheus:时序数据库,按时间保存监控历史数据。语言:Go

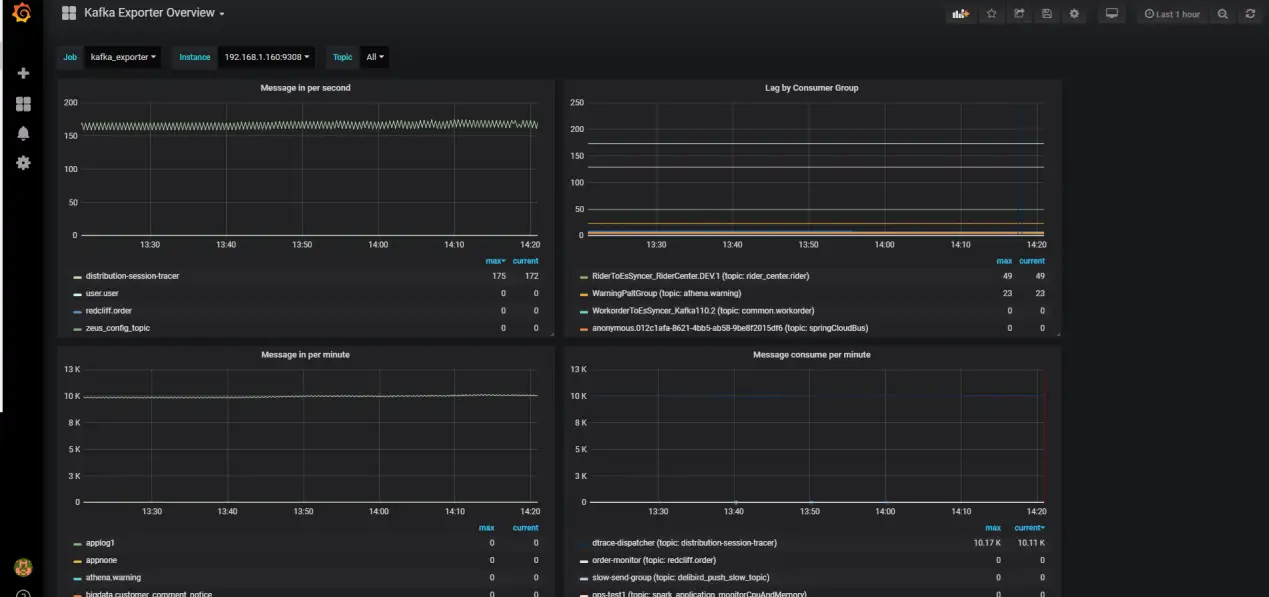

Grafana:metrics 可视化系统

Kafka Exporter:一个用Go 语言写的 Kafka 外部工具,相比JMX 优势在于不需要消耗 JVM资源,就可以对 Kafka 集群进行监控

Kafka Export : 每个 kafka 集群一个。需要一个端口

Prometheus 和 Grafana 可以部署在同一台服务器,也可以分开部署

Tar xzvf kafka_exporter-1.2.0.linux-amd64.tar.gz

Cd kafka_exporter-1.2.0.linux-amd64

启动监控工具

nohup ./kafka_exporter \

--kafka.server=192.168.1.160:19092 \

--kafka.version=1.1.0 --log.level=info > kafka_exporter.log --web.listen-address=9308 &

# --kafka.server=kafka_broker_address

# --kafka.version=kafka_version

# --log.leve=日志等级复制更详细的配置参阅:

https://github.com/danielqsj/kafka_exporter#run-binary

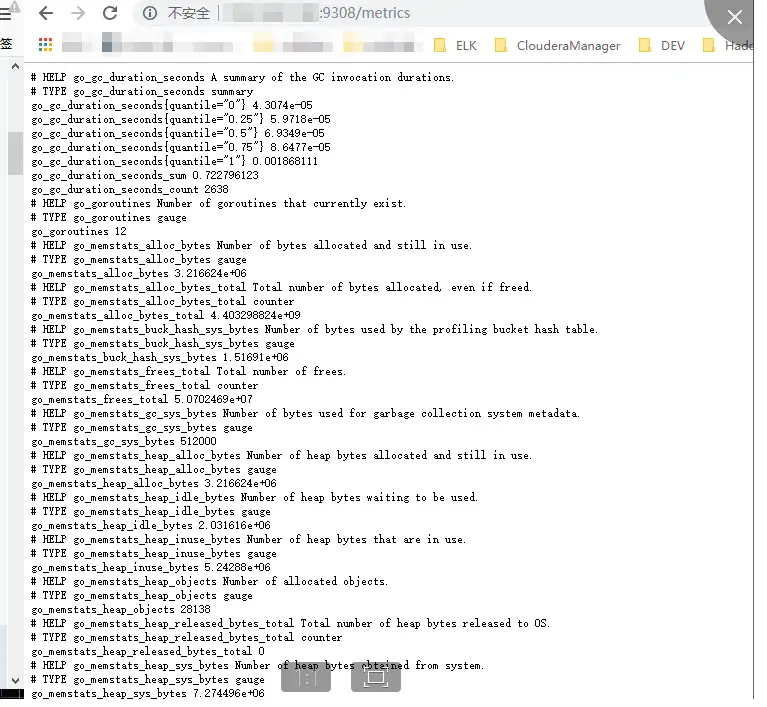

启动完成后访问以下地址:

http://192.168.1.1:9308/metrics

可以看到 Prometheus 格式数据

下载 Prometheus 安装包

Tar xzvf prometheus-2.6.0.linux-amd64.tar.gz

Cd prometheus-2.6.0.linux-amd64

Vim Prometheus.yml

添加红框中的内容,注意这是 yml 文件格式要求很严格

启动 Prometheus

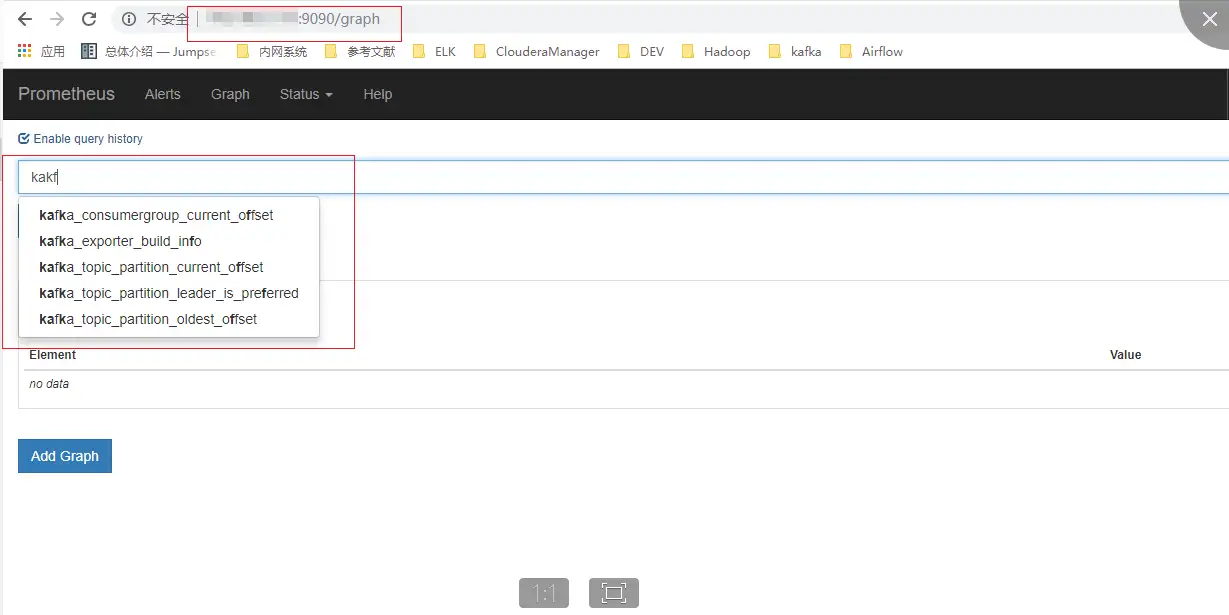

nohup ./prometheus --config.file=prometheus.yml > prometheus.log &复制登录 Prometheus 控制台

可以检索到 kafka 的数据

下载 Grafana

wget https://dl.grafana.com/oss/release/grafana-5.4.2-1.x86_64.rpm

sudo yum localinstall grafana-5.4.2-1.x86_64.rpm

systemctl start grafana-server

systemctl enable grafana-server复制访问 已经安装好的 Grafana 地址

默认用户名/密码:admin/admin

添加数据源

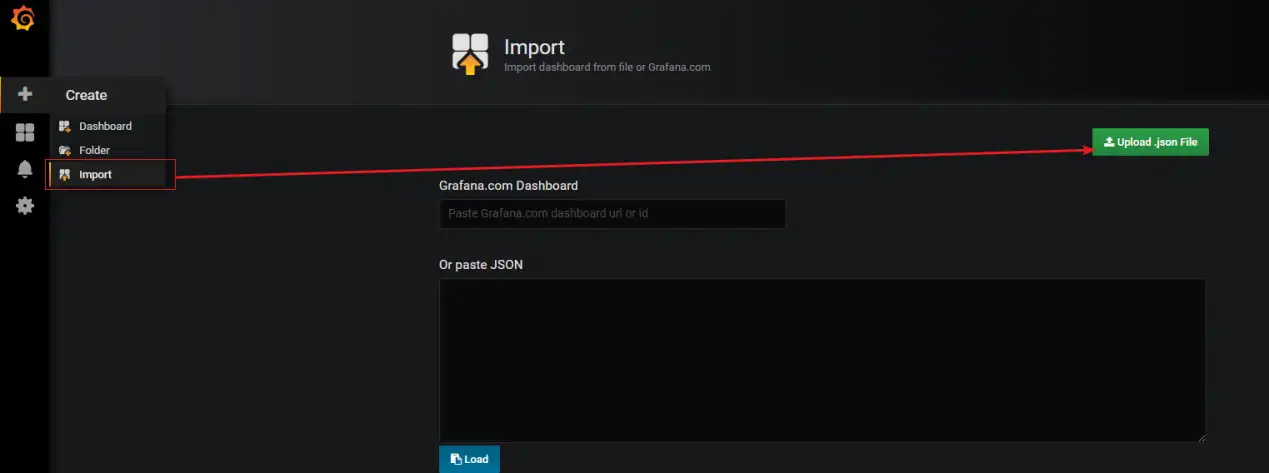

下载 Kafka Exporter 模板

wget https://grafana.com/api/dashboards/7589/revisions/5/download复制导入 Kafka Exporter 模板

选择数据源。因为我已经配置过,所以会有提示。

然后我们就可以在 dashboard 中看见 kafka 历史/实时数据监控了。