中断是系统用来响应硬件设备请求的一种机制,它会打断进程的正常调度和执行,然后调用内核中的中断处理程序来响应设备的请求。

一、 为什么要有中断

举个生活中的例子,让你感受一下中断的魅力。比如说你订了一份外卖,但是不确定外卖什么时候送到,也没有别的方法了解外卖的进度,但是,配送员送外卖是不等人的,到了你这儿没人取的话,就直接走人了。所以你只能苦苦等着,时不时去门口看看外卖送到没,而不能干其他事情。不过呢,如果在订外卖的时候,你就跟配送员约定好,让他送到后给你打个电话,那你就不用苦苦等待了,就可以去忙别的事情,直到电话一响,接电话、取外卖就可以了。

这里的“打电话”,其实就是一个中断。没接到电话的时候,你可以做其他的事情;只有接到了电话(也就是发生中断),你才要进行另一个动作:取外卖。这个例子你就可以发现,中断其实是一种异步的事件处理机制,可以提高系统的并发处理能力。

由于中断处理程序会打断其他进程的运行,所以,为了减少对正常进程运行调度的影响,中断处理程序就需要尽可能快地运行。如果中断本身要做的事情不多,那么处理起来也不会有太大问题;但如果中断要处理的事情很多,中断服务程序就有可能要运行很长时间。特别是,中断处理程序在响应中断时,还会临时关闭中断。这就会导致上一次中断处理完成之前,其他中断都不能响应,也就是说中断有可能会丢失。

假如你订了 2 份外卖,一份主食和一份饮料,并且是由 2 个不同的配送员来配送。这次你不用时时等待着,两份外卖都约定了电话取外卖的方式。但是,问题又来了。当第一份外卖送到时,配送员给你打了个长长的电话,商量发票的处理方式。与此同时,第二个配送员也到了,也想给你打电话。但是很明显,因为电话占线(也就是关闭了中断响应),第二个配送员的电话是打不通的。所以,第二个配送员很可能试几次后就走掉了(也就是丢失了一次中断)。

二、 硬中断与软中断

如果你弄清楚了“取外卖”的模式,那对系统的中断机制就很容易理解了。事实上,为了解决中断处理程序执行过长和中断丢失的问题,Linux 将中断处理过程分成了两个阶段,也就是上半部和下半部:

- 上半部(硬中断)用来快速处理中断,它在中断禁止模式下运行,主要处理硬件相关或时间敏感的工作,特点是快速执行

- 下半部(软中断)用来延迟处理上半部未完成的工作,通常以内核线程的方式运行,特点是延迟执行

- 个人理解,“硬”可以理解为硬件相关,也可以理解为真正会影响到别的中断响应,所以上半部叫硬中断

- 每个 CPU 都对应一个软中断内核线程,名字为 “ksoftirqd/CPU编号”,比如 0 号 CPU 对应的软中断内核线程的名字就是 ksoftirqd/0

- 一些内核自定义的事件也属于软中断,比如内核调度和 RCU 锁(Read-Copy Update 的缩写,RCU 是 Linux 内核中最常用的锁之一)等。

比如说前面取外卖的例子,上半部就是你接听电话,告诉配送员你已经知道了,其他事儿见面再说,然后电话就可以挂断了;下半部才是取外卖的动作,以及见面后商量发票处理的动作。这样,第一个配送员不会占用你太多时间,当第二个配送员过来时,照样能正常打通你的电话。

我再举个最常见的网卡接收数据包的例子,让你更好地理解。网卡接收到数据包后,会通过硬件中断的方式,通知内核有新的数据到了。这时,内核就应该调用中断处理程序来响应它,这种情况下的上半部和下半部分别负责什么工作呢?

- 对上半部来说,既然是快速处理,其实就是要把网卡的数据读到内存中,然后更新一下硬件寄存器的状态(表示数据已经读好了),最后再发送一个软中断信号,通知下半部做进一步的处理。

- 下半部被软中断信号唤醒后,需要从内存中找到网络数据,再按照网络协议栈,对数据进行逐层解析和处理,直到把它送给应用程序。

三、 查看软中断和内核线程

不知道你还记不记得前面提到过的 proc 文件系统,它是一种内核空间和用户空间进行通信的机制,可以用来查看内核的数据结构,或者用来动态修改内核的配置。其中:

- /proc/interrupts 提供了硬中断的运行情况

- /proc/softirqs 提供了软中断的运行情况;

cat /proc/softirqsCPU0 CPU1HI: 0 0TIMER: 811613 1972736NET_TX: 49 7NET_RX: 1136736 1506885BLOCK: 0 0IRQ_POLL: 0 0TASKLET: 304787 3691SCHED: 689718 1897539HRTIMER: 0 0RCU: 1330771 1354737复制在查看 /proc/softirqs 文件内容时,你要特别注意以下这两点。

- 注意软中断的类型,也就是第一列的内容。从第一列你可以看到,软中断包括了 10 个类别,分别对应不同的工作类型。比如 NET_RX 表示网络接收中断,而NET_TX 表示网络发送中断。

- 注意同一种软中断在不同 CPU 上的分布情况,也就是该行后面各列的内容。正常情况下,同一种中断在不同 CPU 上的累积次数应该差不多。比如这个界面中,NET_RX 在CPU0 和 CPU1 上的中断次数基本是同一个数量级,相差不大。

不过你可能发现,TASKLET 在不同 CPU 上的分布并不均匀。TASKLET 是最常用的软中断实现机制,每个 TASKLET 只运行一次就会结束 ,并且只在调用它的函数所在的 CPU 上运行,因此,使用 TASKLET 特别简便。当然也会存在一些问题,比如说由于只在一个 CPU 上运行导致的调度不均衡,再比如因为不能在多个 CPU 上并行运行带来了性能限制。

另外,刚刚提到过,软中断实际上是以内核线程的方式运行的,每个 CPU 都对应一个软中断内核线程,这个软中断内核线程就叫做 ksoftirqd/CPU 编号。那要怎么查看这些线程的运行状况呢?其实用 ps 命令就可以做到:

ps aux | grep softirqroot 7 0.0 0.0 0 0 ? S Oct10 0:01 [ksoftirqd/0]root 16 0.0 0.0 0 0 ? S Oct10 0:01 [ksoftirqd/1]复制

注意,这些线程的名字外面都有中括号,这说明 ps 无法获取它们的命令行参数(cmline)。一般来说,ps 的输出中,名字括在中括号里的都是内核线程。

四、 软中断案例分析

当软中断事件的频率过高时,内核线程也会因为 CPU 使用率过高而导致软中断处理不及时,进而引发网络收发延迟、调度缓慢等性能问题。软中断 CPU 使用率过高也是一种最常见的性能问题,如果遇到了,该怎么办?

1. 一些新工具

这里用到了三个新工具,sar、 hping3 和 tcpdump,先简单介绍一下:

- sar 是一个系统活动报告工具,既可以实时查看系统的当前活动,又可以配置保存和报告历史统计数据。

- hping3 是一个可以构造 TCP/IP 协议数据包的工具,可以对系统进行安全审计、防火墙测试等。

# 模拟 Nginx 的客户端请求(这是一个简单的 SYN FLOOD 攻击)# -S参数表示设置TCP协议的SYN(同步序列号),-p表示目的端口为80,-i u100表示每隔100微秒发送一个网络帧# 注:如果你在实践过程中现象不明显,可以尝试把100调小,比如调成10甚至1hping3 -S -p 80 -i u100 192.168.0.30复制- tcpdump 是一个常用的网络抓包工具,常用来分析各种网络问题。

2. 现象与分析思路

目前系统超级卡,简单的 SHELL 命令都明显变慢了,先看看系统的整体资源使用情况。

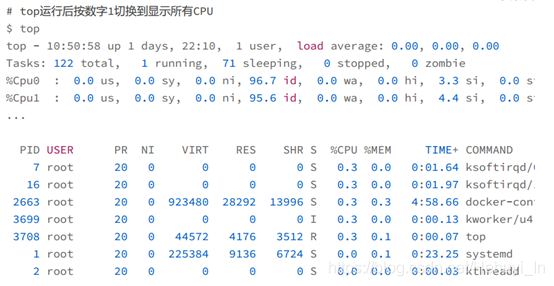

这里你有没有发现异常的现象?我们从第一行开始,逐个看一下:

- 平均负载全是 0,就绪队列里面只有一个进程(1 running)。

- 每个 CPU 的使用率都挺低,最高也只有 4.4%,并不算高。

- 再看进程列表,CPU 使用率最高的进程也只有 0.3%,还是不高呀。

那为什么系统的响应变慢了呢?既然每个指标的数值都不大,那我们就再来看看,这些指标对应的更具体的含义。毕竟,哪怕是同一个指标,用在系统的不同部位和场景上,都有可能对应着不同的性能问题。

仔细看 top 的输出,两个 CPU 的使用率虽然分别只有 3.3% 和 4.4%,但都用在了软中断上;而从进程列表上也可以看到,CPU 使用率最高的也是软中断进程 ksoftirqd。看起来,软中断有点可疑了。

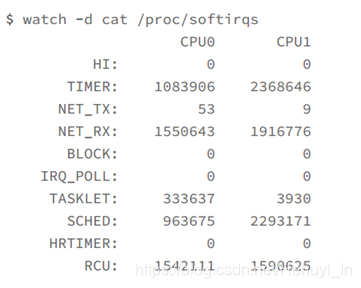

既然软中断可能有问题,那你先要知道,究竟是哪类软中断的问题。观察 /proc/softirqs 文件的内容,就能知道各种软中断类型的次数。不过,这里的次数是系统运行以来的累积中断次数,所以直接查看文件内容,对这里的问题并没有直接参考意义。因为,这些中断次数的变化速率才是我们需要关注的。

什么工具可以观察命令输出的变化情况呢?在前面案例中用过的 watch 命令就可以定期运行一个命令来查看输出;如果再加上 -d 参数,还可以高亮出变化的部分,直观看出哪些内容变化得更快。

watch -d cat /proc/softirqs复制

通过 /proc/softirqs 文件内容的变化情况,你可以发现, TIMER(定时中断)、NET_RX(网络接收)、SCHED(内核调度)、RCU(RCU 锁)等这几个软中断都在不停变化。其中,NET_RX(网络数据包接收软中断)的变化速率最快。而其他几种类型的软中断,是保证 Linux 调度、时钟和临界区保护这些正常工作所必需的,所以它们有一定的变化倒是正常的。

3. 用sar分析网络软中断

既然是网络接收的软中断,第一步应该就是观察系统的网络接收情况。

sar 可以用来查看系统网络收发的BPS(每秒收发的字节数)和网络收发的 PPS(每秒收发的网络帧数)

# -n DEV 表示显示网络收发的报告,间隔1秒输出一组数据$ sar -n DEV 1复制

- 第一列:表示报告的时间

- 第二列:IFACE 表示网卡

- 第三、四列:rxpck/s 和 txpck/s 分别表示每秒接收、发送的网络帧数,也就是 PPS。

- 第五、六列:rxkB/s 和 txkB/s 分别表示每秒接收、发送的千字节数,也就是 BPS。

- 后面的其他参数基本接近 0,显然跟今天的问题没有直接关系,你可以先忽略掉。

我们具体来看输出的内容,你可以发现:

- 对网卡 eth0 来说,每秒接收的网络帧数比较大,达到了 12607,而发送的网络帧数则比较小,只有 6304;每秒接收的千字节数只有 664 KB,而发送的千字节数更小,只有358 KB。

- docker0 和 veth9f6bbcd 的数据跟 eth0 基本一致,只是发送和接收相反,发送的数据较大而接收的数据较小。这是 Linux 内部网桥转发导致的,你暂且不用深究,只要知道这是系统把 eth0 收到的包转发给 Nginx 服务即可。

从这些数据,你有没有发现什么异常的地方?

既然怀疑是网络接收中断的问题,我们还是重点来看 eth0 :接收的 PPS 比较大,达到12607,而接收的 BPS 却很小,只有 664 KB。直观来看网络帧应该都是比较小的,我们稍微计算一下,664*1024/12607 = 54 字节,说明平均每个网络帧只有 54 字节,这显然是很小的网络帧,也就是我们通常所说的小包问题。

那么,有没有办法知道这是一个什么样的网络帧,以及从哪里发过来的呢?

4. tcpdump 抓包

使用 tcpdump 抓取 eth0 上的包就可以了。我们已经知道, Nginx 监听在 80 端口,它所提供的 HTTP 服务是基于 TCP 协议的,所以我们可以指定 TCP 协议和 80 端口精确抓包。

接下来,我们在第一个终端中运行 tcpdump 命令,通过 -i eth0 选项指定网卡 eth0,并通过 tcp port 80 选项指定 TCP 协议的 80 端口

# -i eth0 只抓取eth0网卡,-n不解析协议名和主机名# tcp port 80表示只抓取tcp协议并且端口号为80的网络帧$ tcpdump -i eth0 -n tcp port 8015:11:32.678966 IP 192.168.0.2.18238 > 192.168.0.30.80: Flags [S], seq 45830361复制从 tcpdump 的输出中,你可以发现

192.168.0.2.18238 > 192.168.0.30.80 ,表示网络帧从 192.168.0.2 的 18238 端口发送到 192.168.0.30 的 80 端口,也就是从运行 hping3 机器的 18238 端口发送网络帧,目标为 Nginx 所在机器的 80 端口。Flags [S] 则表示这是一个 SYN 包。

再加上前面用 sar 发现的, PPS 超过 12000 的现象,现在我们可以确认,这就是从192.168.0.2 这个地址发送过来的 SYN FLOOD 攻击。

5. 小结

到这里,我们已经做了全套的性能诊断和分析。从系统的软中断使用率高这个现象出发,通过观察 /proc/softirqs 文件的变化情况,判断出软中断类型是网络接收中断;再通过 sar和 tcpdump ,确认这是一个 SYN FLOOD 问题。

SYN FLOOD 问题最简单的解决方法,就是从交换机或者硬件防火墙中封掉来源 IP,这样SYN FLOOD 网络帧就不会发送到服务器中。至于 SYN FLOOD 的原理和更多解决思路,你暂时不需要过多关注,后面的网络章节里我们都会学到。