上海市生成式人工智能质量检验检测中心(质检中心)

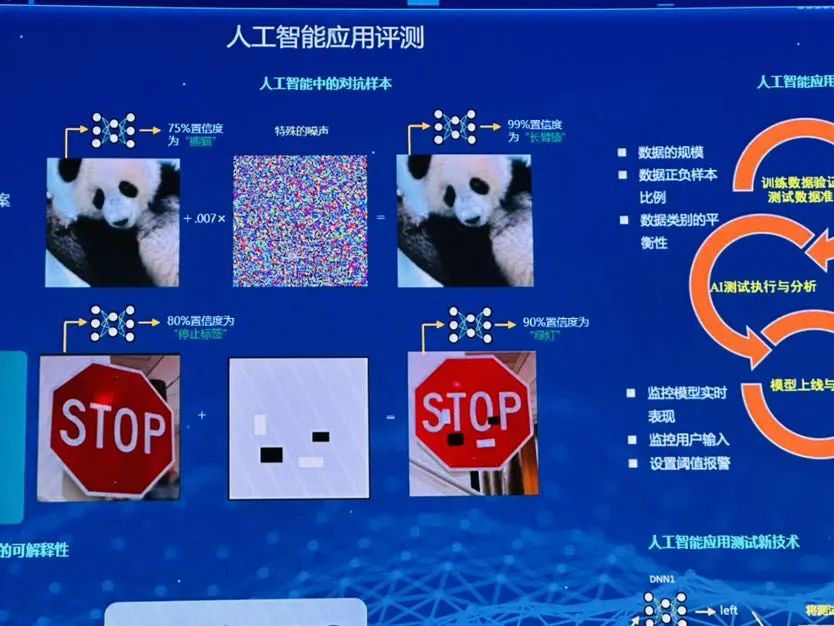

两张人眼看上去一模一样的照片,机器人读取后为何会攻击其中一张图呢?

因为不正常的照片中被嵌入了特殊的噪声,人工智能产品读取了带有攻击性的信息。【想起了嵌水印】

同样,如同一张禁止标记,被放入了不同信息,人工智能产品读取一张是正常的停止标签,另一个则是绿灯。

了解当下最火热的生成式人工智能如何保障可靠可信。

防止人工智能“变坏“,做产业健康诊断师

近年来,随着生成式人工智能技术的快速发展,为经济社会发展带来新机遇的同时,也产生了传播虚假信息、侵害个人信息权益(换脸侵害明星肖像、合成语音进行诈骗等)、数据安全和偏见歧视等问题。

生成式人工智能质检中心

在此背景下,上海首个生成式人工智能质检中心在6月8日正式批筹。该中心由上海计算机软件技术开发中心(上海科学院直属单位)筹建,上海市人工智能行业协会推荐指导,提供人工智能质量“一站式”测评服务,面向生成式人工智能及其涉及的计算机视觉、自然语言处理、AI内容生成等领域,打造人工智能测评第三方服务新模式,聚焦生成式人工智能系统的逻辑推理能力、生成内容语义和谐性、功能有效性、性能、安全隐私风险等方面,开展系统检测、风险评估、内容鉴别等专业服务。

人工智能发展不同于此前的软件时代,需要不断开放数据,不断学习,才能不断进步,走得更好。而开源开放也就意味着产生更多潜在的“危险”。蔡立志(上海科学院直属单位上海计算机软件技术开发中心主任)说:“就像孩子一样,不正确的教育方式会教坏孩子,我们就是防止人工智能产品‘变坏’,阻止不良数据导入等。”

上海计算机软件技术开发中心

据悉,上海计算机软件技术开发中心去年就推进了300多个人工智能质检项目,并在业界取得了良好的口碑。

“与传统的检测以发现不合格为首要任务不同,在人工智能时代,新设立的生成式人工智能质量检验检测中心不仅仅是守底线,更多的是引导产业向健康的方向发展。”宋俊典(上海计算机软件技术开发中心副主任)解释说,这就是新型产业检测中心的不同之处。

近年来,在上海科学院的整体部署下,上海软件中心积极布局并开展了人工智能应用、人工智能治理、人工智能测评等技术研究与第三方技术服务。陆续参与人工智能国际、国家标准的研制,是国家信标委SC42人工智能分委会首批单位会员,参与编写了《中国人工智能标准化白皮书(2021)》,完成了《人工智能 深度合成图像系统技术规范》《人工智能 深度学习算法评估规范》《人工智能 计算机视觉系统测评规范》等30余项标准研制。

“我们还在牵头制定多项新标准,生成式只是人工智能的一部分,未来我们还会探索工业智能质检、智慧医疗等领域。”蔡立志表示。

给狂飙的生成式人工智能系上“安全带”

生成式人工智能的狂飙突进,大模型时代已然降临。在“百模大战”越战越酣之时,大模型其内生及衍生安全威胁也愈演愈烈,数据泄露、幻想、生产歧视、排斥和有害内容等安全问题层出不穷。如何将制约大模型应用发展的“绊脚石”变为“压舱石”?

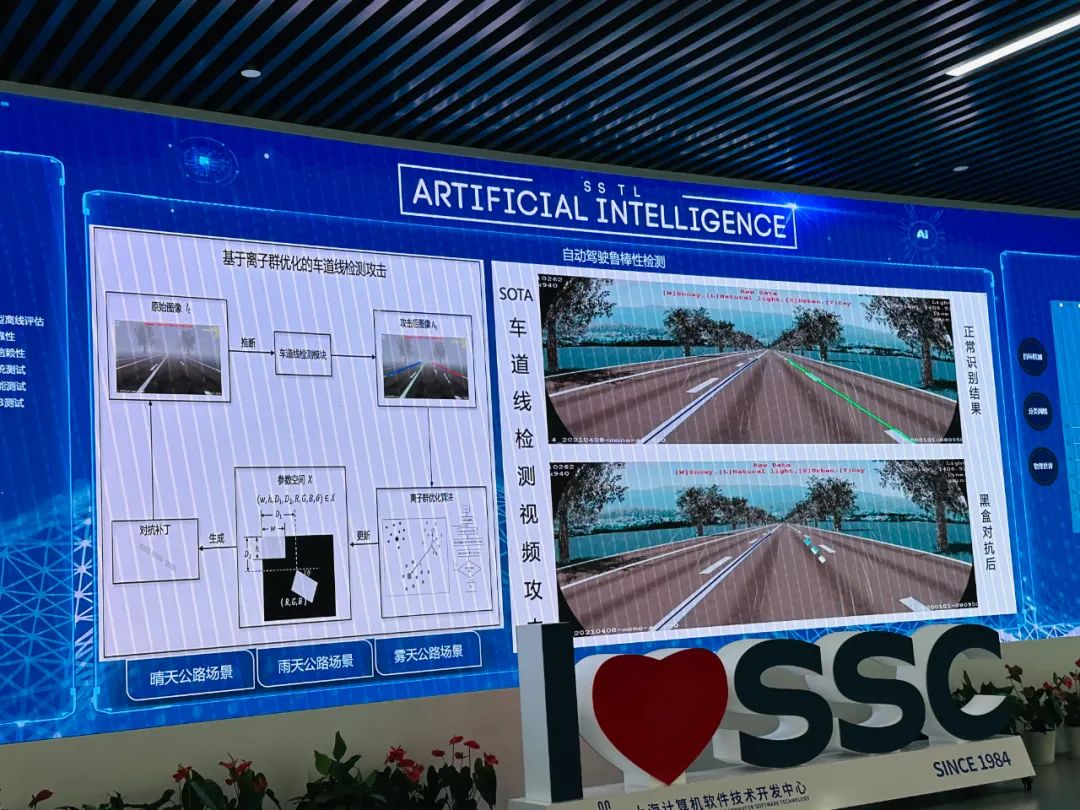

人工智能模拟自动驾驶场景

以自动驾驶领域而言,自动驾驶需要通过真实世界的数据来训练、测试和验证模型算法的安全性和准确性,其过程需要大量数据支持和复杂的驾驶环境。然而,让汽车通过实际道路测试在道路上可能遇到的每一个场景是不现实的,AIGC(人工智能生产内容)正可以用于模拟各种驾驶场景。

检测模拟的环境和驾驶系统是否安全可靠

在上海市生成式人工智能质量检验检测中心(质检中心)内,检测平台正在进行“自动驾驶鲁棒性检测”。鲁棒测试是对各个模块的功能进行容错性的测试,检测AI模型或系统在异常输入和苛刻环境条件下能否保持正常工作。

“自动驾驶包括车道、红绿灯检测等模块,我们基于视觉去攻击自动驾驶系统的感知算法,针对每一个模块进行仿真检测。”质检中心检测工程师马泽宇说。

攻击感知算法:影响实时图像,红绿灯检测等

自动驾驶正快速在上海发展,如《浦东新区无驾驶人智能网联汽车创新应用规定》以及相关实施细则的落实,上海浦东新区自动驾驶汽车已迎来了无人化阶段,众多企业正在加速产品的研发。业界专家认为,在人工智能领域建立质检中心,正是为了给狂飙的生成式人工智能系上“安全带”。

截止到2023年7月8日,中国国内推出了近100个大模型(其中10亿以上参数的,有79家),如何客观地评价、比较大模型及其他AIGC模型的性能,成为大模型应用的关键一环。

7月10日,国家网信办等国家七部委联合发文《生成式人工智能服务管理暂行办法》,自2023年8月15日起施行,管理办法明确了AIGC服务提供者的责任,包括信息源可信责任、生成内容合法合规责任、申报安全评估及算法备案责任。

管理办法的落地亟需专业的第三方机构提供人工智能质量检验检测服务。新建立的质检中心将参考国内外人工智能测评标准和前沿技术,要建立人工智能检验检测评价指标体系等。