大模型材料收集

近期生成式人工智能工具的爆发与隐私立法的激增在美国和全球范围内同时发生。在美国,仅不到三年时间内就有13个州通过了全面的数据保护法律。在全球范围内,大多数发达国家在过去十年内都通过了新的或更严格的隐私法律。这些法律中许多都明确地规定了对人工智能应用的监管。因此将个人数据输入生成式人工智能工具并处理其输出中的个人数据,需要应对复杂的数据保护义务。

在这个复杂领域中存在三个关键问题:

在好未来 20 周年直播活动中,CTO 田密宣布好未来自研的数学领域千亿级大模型 MathGPT 开启内测。MathGPT 是面向全球数学爱好者和科研机构,以解题和讲题算法为核心的数学垂直领域的大模型,也是国内首个专为数学打造的大模型。

使用方式也很简单,用户使用 MathGPT 时,用文字或图片方式上传数学题,即可得到对话式的解答反馈,也可以通过 “随机来一题” 的按钮,随机生成数学题目并由系统给出解答。

MathGPT 的数学计算能力已覆盖小学、初中、高中的数学题,题目类型涵盖计算题、应用题、代数题等多个类型,还可以针对题目进行追问。不过暂未开放数学之外的问答互动。

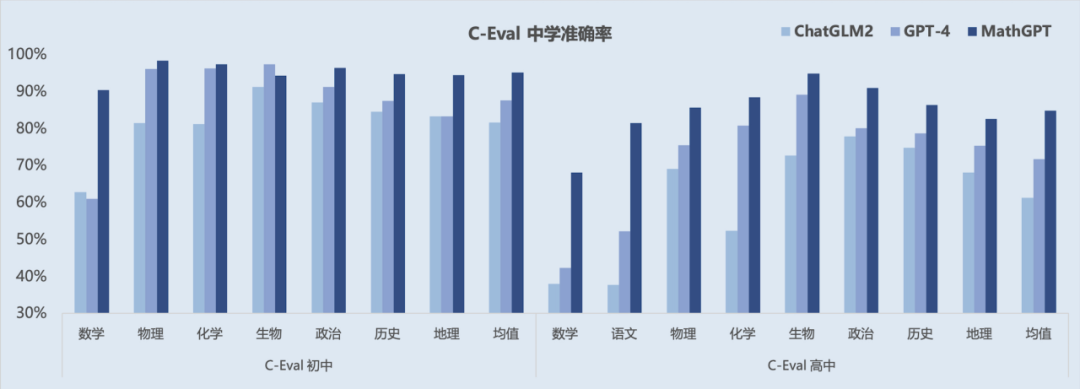

在 CEval-Math、AGIEval-Math、APE5K、CMMLU-Math、高考数学和 Math401 等 6 个公开数学评测集合的测试结果中,MathGPT 取得了多项测试的最高分数。同时,MathGPT 在 C-Eval 的初高中的全科测试集合上也均有不错的表现。

在解题稳定性、讲解友好度方面,MathGPT 基于海量名师解题过程的数据进行模型训练,模型的解题步骤专业清晰。

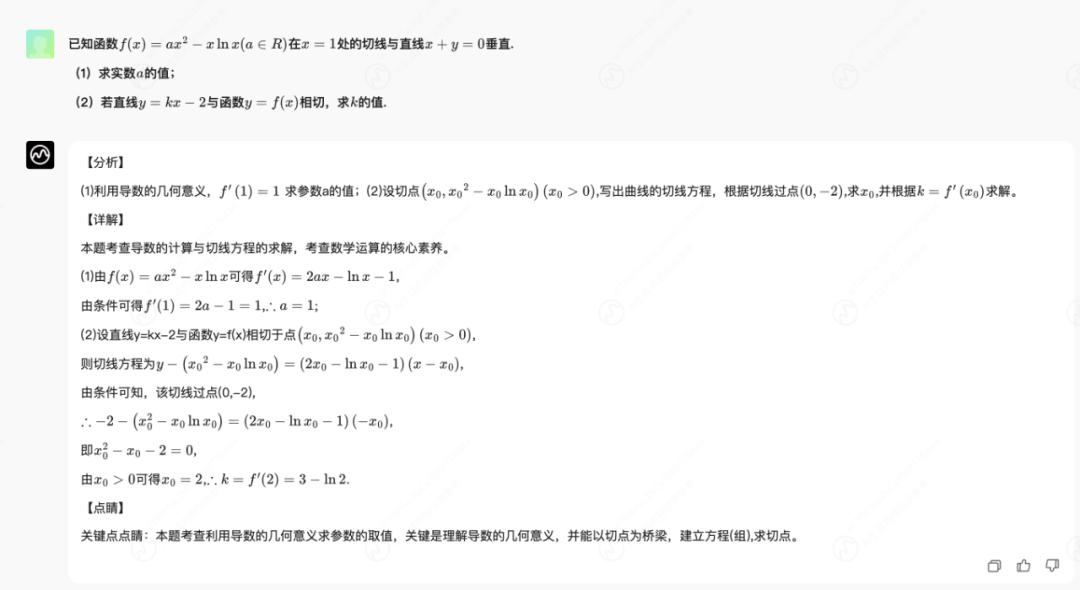

我们以一道数列题为例,MathGPT 给出的答案包含 “分析”、“详解”、“点睛” 三个部分,比通用大模型的粗略讲解方式更为细致。其中“分析” 提供了题目的解题思路、思考方式,帮助用户更好地理解题目;“详解” 则给出具体的计算方式和答案;最后 “点睛” 的环节对题目的考点、难点、关键点进行提示,帮助用户回顾反思出题意图、举一反三。

MathGPT 能实现更高准确度的解题,也能把答案解析得更清楚、讲解得更明白,更好地满足用户使用 AI 产品解答数学问题的核心需求。

2023年7月7日,华为开发者大会发布盘古大模型3.0,盘古大模型采用L0、L1、L2三层“5+N+X”架构。

L0层包括自然语言、视觉、多模态、预测、科学计算五个基础大模型,提供满足行业场景中的多种技能需求。盘古3.0可以提供100亿参数、380亿参数、710参数和1000亿参数的系列化基础大模型,匹配不同场景、不同时延、不同响应速度的行业多样化需求。同时提供全新能力集,包括NLP大模型的知识问答、文案生成、代码生成,以及多模态大模型的图像生成、图像理解等能力。 (基础大模型)

L1层是N个行业大模型,华为云提供使用行业公开数据训练的行业通用大模型,包括政务,金融,制造,矿山,气象等大模型;也可以基于行业客户的自有数据,在盘古大模型的L0和L1层上训练专有大模型。(领域大模型)

L2层提供了更多细化场景的模型,更加专注于政务热线、网点助手、先导药物筛选、传送带异物检测、台风路径预测等具体行业应用或特定业务场景,其华为云盘古气象大模型研究成果在《Nature》正刊发表。提供“开箱即用”的模型服务。(专业大模型)

华为盘古大模型不同领域不同场景下的应用:

盘古大模型采用完全的分层解耦设计,客户既可以为自己的大模型加载独立的数据集,也可以单独升级基础模型,也可以单独升级能力集。在L0和L1大模型的基础上,华为云提供了大模型行业开发套件,通过对需求方自有数据的二次训练,可以获取专属行业大模型。同时,根据不同的数据安全与合规诉求,盘古大模型还提供了公用云、大模型云专区、混合云多样化的部署形态。

阿里云推出大规模视觉语言模型Qwen-VL,开源。

Qwen-VL以通义千问70亿参数模型Qwen-7B为基座语言模型研发,支持图文输入,具备多模态信息理解能力。在主流的多模态任务评测和多模态聊天能力评测中,Qwen-VL取得了远超同等规模通用模型的表现。

Qwen-VL是支持中英文等多种语言的视觉语言(Vision Language,VL)模型,相较于此前的VL模型,Qwen-VL除了具备基本的图文识别、描述、问答及对话能力之外,还新增了视觉定位、图像中文字理解等能力。

Qwen-VL及其视觉AI助手Qwen-VL-Chat均已上线ModelScope魔搭社区,开源、免费、可商用。

用户可从魔搭社区直接下载模型,也可通过阿里云灵积平台访问调用Qwen-VL和Qwen-VL-Chat。

ModelScope魔搭社区:

魔搭社区模型体验:https://modelscope.cn/studios/qwen/Qwen-VL-Chat-Demo/summary

HuggingFace:

Qwen-VL-Chat:https://huggingface.co/Qwen/Qwen-VL-Chat

Qwen-VL 模型的训练分为三个阶段:

Qwen-VL 模型的研发难点主要体现在数据、训练、框架三个层面。数据方面,多模态的数据整理和清洗是个难点,有效的数据清洗可以提高训练效率以及提升最终收敛后的效果;训练方面,在多模态大模型的训练中,一般认为大 batch 和较大学习率可以提升训练收敛效率和最终结果,但其训练过程可能更加不稳定,通过一些训练技巧有效提升了训练稳定性;框架方面,目前多模态大模型的并行训练框架支持并不完善,通过对多模态大模型的 3D 并行技术进行了优化,可稳定训练更大规模的多模态模型。

Qwen-VL-Chat 是在 Qwen-VL 的基础上,使用对齐机制打造的基于大语言模型的视觉 AI 助手,可让开发者快速搭建具备多模态能力的对话应用。

其一是使用标准基准数据集来评测每个多模态子任务的效果。例如评测图片描述(Image Captioning)、图片问答(Visual Question Answering, VQA)、文档问答(Document VQA)、图表问答(Chart VQA)、少样本问答(Few-shot VQA)、参照物标注(Referring Expression Comprehension)等。其二是使用人工或借助 GPT-4 打分来评测多模态大模型的整体对话能力和对齐水平。通义千问团队构建了一套基于 GPT-4 打分机制的基准“试金石”( TouchStone),总计涵盖 300+张图片、800+ 道题目、27 个题目类别。

多模态大模型开发难度

模态间表征差异大:大规模纯语言模型的输入输出一般是离散表征,而图像、语音等内容通常是连续表征,其模态间的信息密度、表征空间、输入输出方式等都存在巨大差异,这导致了设计的复杂性。

多模态大模型收敛不稳定:由于模态间表征差异大、各模态网络异构等因素,相比纯文本大模型,多模态大模型的训练具有更多的挑战,更有可能出现训练不稳定的情况。

缺乏稳定开源框架支持:目前常见的开源大模型训练框架,都只对纯语言模型的训练效率进行了极致的优化。为了处理多模态输入输出,多模态模型通常有非对称的网络结构,导致无法直接用常见开源训练框架扩展到超大参数量。

作者观点:坚定地支持通用大模型的,觉得行业大模型的前景堪忧。

最近,来自杜伦大学等三所高校的研究人员训练了个AI模型,让声学攻击变得无比简单,通过分析键盘声音,就能重构用户输入的密码和敏感信息。

绿盟安全大模型是集绿盟科技二十余年网络安全深耕与十余年AI安全研究实践于一身的安全行业垂直领域大模型,是基于海量安全专业知识训练,构建的一套覆盖安全运营、检测响应、攻防对抗、知识提供等多种场景的网络安全运营辅助决策系统。

2023年8月23日,2023 RISC-V 中国峰会在北京召开。会上,平头哥发布首个自研 RISC-V AI 平台,通过软硬件深度协同,较经典方案提升超 8 成性能,支持运行 170 余个主流 AI 模型,推动 RISC-V 进入高性能 AI 应用时代。

RISC-V 架构开源、精简、可扩展性强,在此轮芯片产业周期中发展最为迅速。2022 年全球共生产 100 亿颗 RISC-V 芯片,有一半源于中国。中国工程院院士倪光南在大会致辞中表示,RISC-V 的未来在中国,而中国半导体芯片产业也需要 RISC-V,开源的 RISC-V 已成为中国业界最受欢迎的芯片架构。

平头哥玄铁 RISC-V 高性能全栈技术全新亮相,从处理器 IP 到芯片平台、编译器、工具链等软硬件技术全面升级,并实现 RISC-V 与 Debian、Ubuntu、安卓、OpenKylin、OpenHarmony、龙蜥、酷开 WebOS 等主流操作系统的深度适配,推动 RISC-V 持续向 2GHz 高性能应用演进。

平头哥宣布玄铁处理器全新升级,C920首次加入 Vector1.0,执行GEMM(矩阵的矩阵乘法)计算较Vector方案可提速15倍。平头哥更新自研一站式 AI 部署套件 HHB,在典型网络性能比第三方工具平均提升 88%,并增加支持运行 Transformer、TensorFlow、PyTorch 等 170 余个主流框架 AI 模型,让 RISC-V 真正成为 AI 算力的新选择。

平头哥发布了首个面向多媒体 AI 增强场景的 RISC-V 全栈软硬件平台。该平台将 RISC-V 扩展性的新型 Vector、Matrix 及第三方硬件进行算力抽象,创新接入 OpenCV 与 CSI-NN 等弹性计算库,深度融合多媒体处理流程,形成面向业务的流水线设计,方便用户在流水线的不同步骤上进行 AI 增强优化,为检测、分类、跟踪和超分等各类应用提速。这一平台也获评“2023RISC-V 中国峰会新成果”。

目前,RISC-V 高性能全栈技术在多领域展开规模化落地。平头哥携手合作伙伴,实现首个基于玄铁高性能芯片的安卓商业化项目落地,量产多款视频视觉类产品,推出云计算、智能电视等多场景应用。为吸引更多开发者,平头哥与合作伙伴联合推出玄铁系列开发板,内置玄铁处理器的 Lichee Pi4A、勘智 K230、华山派、BeagleV-Ahead 等已陆续上市。

鸭嘴兽大模型是波士顿大学的研究人员基于Llama2微调而来,目标是在提升性能的同时,使用更少的计算资源和数据,目前一个13B的鸭嘴兽模型可以在单个A100 GPU使用25k个问题在5小时内完成训练。

研究鸭嘴兽70B变强的原因:https://arxiv.org/pdf/2308.07317.pdf

检测测试数据泄露

训练数据污染

清华大学电子工程系日前与字节跳动的火山语音团队携手合作,推出一款开源大语言模型 SALMONN。SALMONN 模型支持语音、音频以及音乐输入,它可以感知和理解不同类型的音频内容输入,并具备多语言语音识别和翻译以及语音推理等功能。

目前 SALMONN 能够胜任英语语音识别、英语到中文的语音翻译、情感识别、音频字幕生成、音乐描述等重要的语音和音频任务,同时又涌现出多种在模型训练中没有专门学习过的多语言和跨模态能力,涵盖非英语语音识别、英语到(中文以外)其他语言的语音翻译、对语音内容的摘要和关键词提取、基于音频的故事生成、音频问答、语音和音频联合推理等任务。

长颈鹿”(Giraffe),基于130亿规模的Llama-2打造,根据上下文长度不同,长劲鹿家族最终一共有三个版本:4k、16k和32k。长颈鹿的作者来自Abacus.AI,这是一家搞AI数据科学平台的初创企业,成立于2019年,已完成5000万元C轮融资。

为了扩展开源模型的上下文长度,他们提出两种新方法:

另外还提出三个新的评估任务:FreeFormQA、AlteredNumericQA和LongChat Lines,其中前两个是一类,为问答任务,第三个为关键值检索任务,结果为:

线性插值是最好的上下文长度外推方法。

所有上下文长度外推方法都随着长度的增加,在任务准确性上出现了下降。

通过在评估阶段使用比微调时更高的比例因子,可以进一步增加上下文长度,但比例因子似乎最多只能提高2倍。