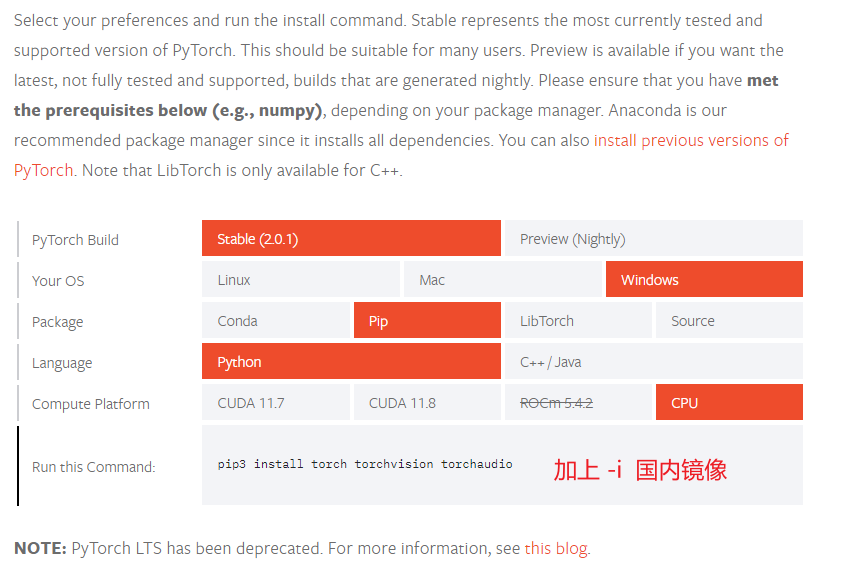

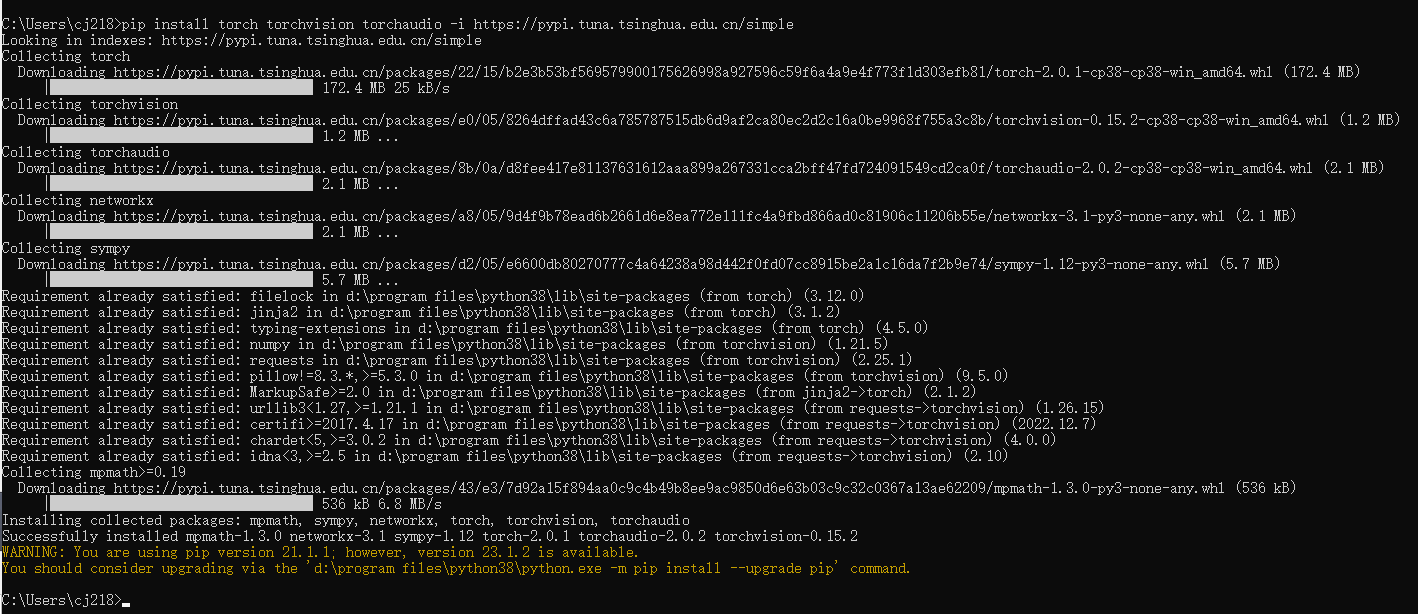

可以使用 Anaconda 安装,我这边直接用 pip 进行安装的

pip install torch torchvision torchaudio -i https://pypi.tuna.tsinghua.edu.cn/simple复制

https://pytorch.org/get-started/locally/

本文简单介绍了使用Python解决使用GPU的方法,并给出了TensorFlow和PyTorch示例;本文还介绍了TensorFlow GPU的安装版本介绍,以及介绍了安装CUDA的详细教程。