本文主要通过例子介绍了如何给核函数计时的思路和实现。实现例子代码参考文献[7],只需要把相应章节对应的CMakeLists.txt文件拷贝到CMake项目根目录下面即可运行。

1.用CPU计时器计时(sumArraysOnGPU-timer.cu)[7]

在主函数中用CPU计时器测试向量加法的核函数,如下所示:

#include <cuda_runtime.h> // 包含cuda运行时系统的头文件

#include <stdio.h> // 包含标准输入输出函数的头文件

#include <time.h> // 包含时间函数的头文件

#include <sys/timeb.h> // 包含时间函数的头文件

//#define CHECK(call) // 定义CHECK宏函数

void initialData(float *ip, int size)

{

// 为随机数生成不同的种子

time_t t; // time_t是一种时间类型

srand((unsigned int) time(&t)); // time()函数返回当前时间的秒数

for (int i = 0; i < size; i++) // 生成随机数

{

ip[i] = (float) (rand() & 0xFF) / 10.0f; // rand()函数用于生成随机数

}

}

void checkResult(float *hostRef, float *gpuRef, const int N) // 检查结果

{

double epsilon = 1.0E-8; // 定义误差范围

bool match = 1; // 定义匹配标志

for (int i = 0; i < N; i++) // 比较每个元素

{

if (abs(hostRef[i] - gpuRef[i]) > epsilon) // 如果误差超过范围

{

match = 0; // 匹配标志置0

printf("Arrays do not match!\n"); // 打印提示信息

printf("host %5.2f gpu %5.2f at current %d\n", hostRef[i], gpuRef[i], i); // 打印不匹配的元素

break;

}

}

if (match) printf("Arrays match.\n\n"); // 如果匹配,打印提示信息

}

void sumArraysOnHost(float *A, float *B, float *C, const int N) // 在主机上计算

{

for (int idx = 0; idx < N; idx++) // 计算每个元素

{

C[idx] = A[idx] + B[idx]; // 计算

}

}

__global__ void sumArraysOnGPU(float *A, float *B, float *C) // 在设备上计算

{

// int i = threadIdx.x; // 获取线程索引

int i = blockIdx.x * blockDim.x + threadIdx.x; // 获取线程索引

// printf("threadIdx.x: %d, blockIdx.x: %d, blockDim.x: %d\n", threadIdx.x, blockIdx.x, blockDim.x); // 打印线程索引

C[i] = A[i] + B[i]; // 计算

}

struct timeval { // 定义timeval结构体

long tv_sec; // 秒

long tv_usec; // 微秒

};

int gettimeofday(struct timeval *tp, void *tzp) { // 定义gettimeofday函数

struct _timeb timebuffer; // 定义_timeb结构体

_ftime(&timebuffer); // 获取当前时间

tp->tv_sec = static_cast<long>(timebuffer.time); // 转换为秒

tp->tv_usec = timebuffer.millitm * 1000; // 转换为微秒

return 0; // 返回0

}

double cpuSecond() { // 定义cpuSecond函数

struct timeval tp; // 定义timeval结构体

gettimeofday(&tp, NULL); // 获取当前时间

return ((double) tp.tv_sec + (double) tp.tv_usec * 1.e-6); // 返回当前时间

}

int main(int argc, char** argv) {

printf("%s Starting...\n", argv[0]); // 打印提示信息

// 设置device

int dev = 0; // 定义device

cudaDeviceProp deviceProp; // 定义deviceProp结构体

// CHECK(cudaGetDeviceProperties(&deviceProp, dev)); // 获取deviceProp结构体

cudaGetDeviceProperties(&deviceProp, dev); // 获取deviceProp结构体

printf("Using Device %d: %s\n", dev, deviceProp.name);

// CHECK(cudaSetDevice(dev)); // 设置device

cudaSetDevice(dev); // 设置device

// 设置vector数据大小

int nElem = 1 << 24; // 定义vector大小,左移24位相当于乘以2的24次方

printf("Vector size %d\n", nElem); // 打印vector大小

// 分配主机内存

size_t nBytes = nElem * sizeof(float);

float *h_A, *h_B, *hostRef, *gpuRef; // 定义主机内存指针

h_A = (float *) malloc(nBytes); // 分配主机内存

h_B = (float *) malloc(nBytes); // 分配主机内存

hostRef = (float *) malloc(nBytes); // 分配主机内存,用于存储host端计算结果

gpuRef = (float *) malloc(nBytes); // 分配主机内存,用于存储device端计算结果

// 定义计时器

double iStart, iElaps;

// 初始化主机数据

iStart = cpuSecond(); // 记录开始时间

initialData(h_A, nElem); // 初始化数据

initialData(h_B, nElem); // 初始化数据

iElaps = cpuSecond() - iStart; // 记录结束时间

memset(hostRef, 0, nBytes); // 将hostRef清零

memset(gpuRef, 0, nBytes); // 将gpuRef清零

// 在主机做向量加法

iStart = cpuSecond(); // 记录开始时间

sumArraysOnHost(h_A, h_B, hostRef, nElem); // 在主机上计算

iElaps = cpuSecond() - iStart; // 记录结束时间

printf("sumArraysOnHost Time elapsed %f sec\n", iElaps); // 打印执行时间

// 分配设备全局内存

float *d_A, *d_B, *d_C;

cudaMalloc((float **) &d_A, nBytes);

cudaMalloc((float **) &d_B, nBytes);

cudaMalloc((float **) &d_C, nBytes);

// 拷贝数据到设备

cudaMemcpy(d_A, h_A, nBytes, cudaMemcpyHostToDevice);

cudaMemcpy(d_B, h_B, nBytes, cudaMemcpyHostToDevice);

// 在设备端调用kernel

int iLen = 1024;

dim3 block(iLen);

dim3 grid((nElem + block.x - 1) / block.x);

iStart = cpuSecond(); // 记录开始时间

sumArraysOnGPU<<<grid, block>>>(d_A, d_B, d_C); // 调用kernel

cudaDeviceSynchronize(); // 同步device

iElaps = cpuSecond() - iStart; // 记录结束时间

printf("sumArraysOnGPU <<<%d, %d>>> Time elapsed %f sec\n", grid.x, block.x, iElaps); // 打印执行时间

// 拷贝结果到主机

cudaMemcpy(gpuRef, d_C, nBytes, cudaMemcpyDeviceToHost);

// 检查结果

checkResult(hostRef, gpuRef, nElem);

// 释放设备内存

cudaFree(d_A);

cudaFree(d_B);

cudaFree(d_C);

// 释放主机内存

free(h_A);

free(h_B);

free(hostRef);

free(gpuRef);

return 0;

}

复制输出结果,如下所示:

Using Device 0: NVIDIA GeForce RTX 3090

Vector size 16777216

sumArraysOnHost Time elapsed 0.059000 sec

sumArraysOnGPU <<<16384, 1024>>> Time elapsed 0.001000 sec

Arrays match.

复制2.用nvprof工具计时(已过时)

nvprof命令行工具可以从应用程序的CPU和GPU活动中获取时间线信息,包括内核执行、内存传输以及CUDA API的调用。使用语法如下所示:

$ nvprof [nvprof_args] <application> [application_args]

$ nvprof --help

$ nvprof ./sumArraysOnGPU-timer

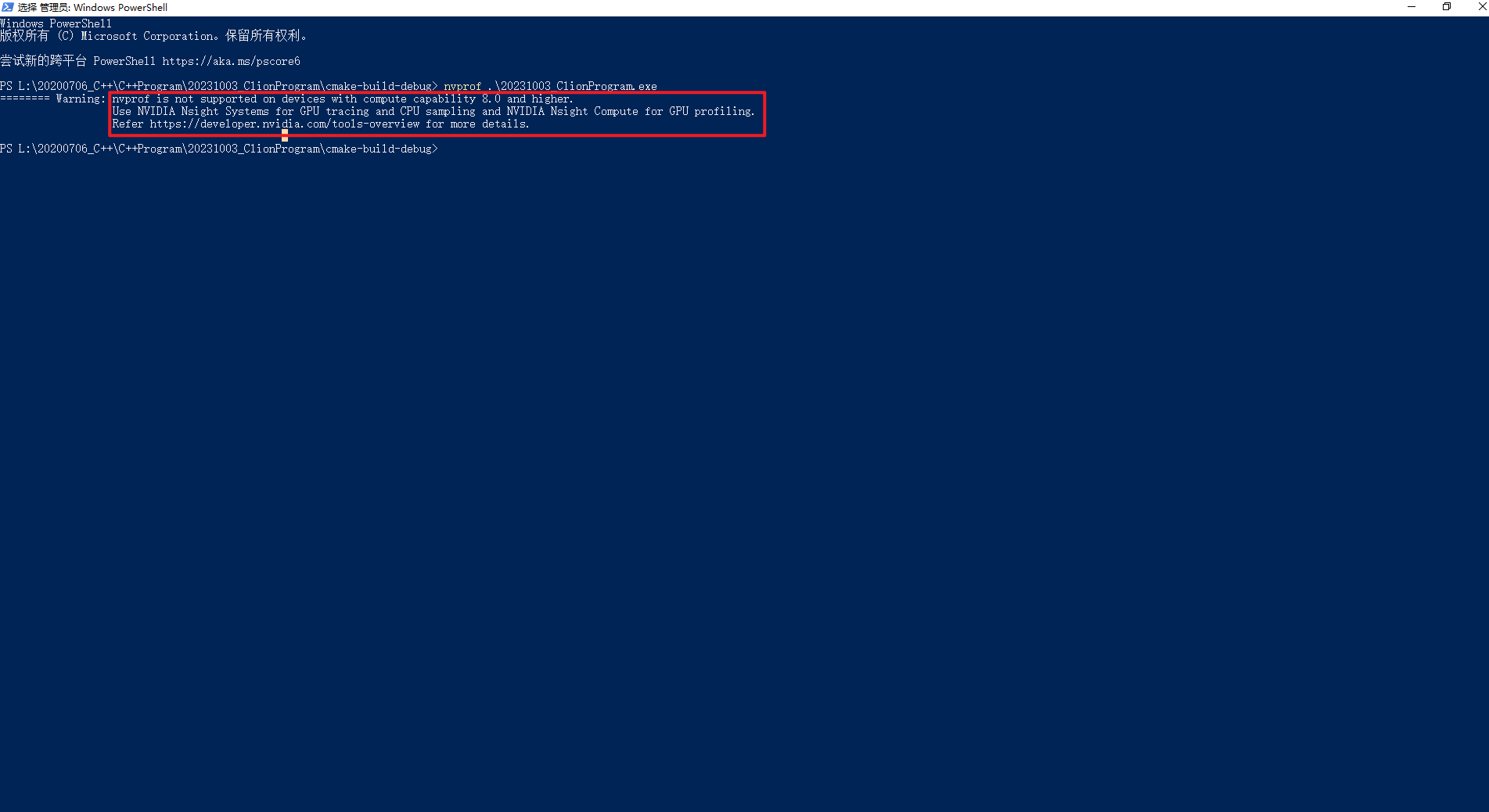

复制 遇到这个错误,将C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.8\extras\CUPTI\lib64添加到Path环境变量中即可,如下所示:

说明:对于计算能力为8.0及更高版本的设备,不支持使用nvprof。对于GPU跟踪和CPU采样,使用NVIDIA Nsight Systems;对于GPU分析,使用NVIDIA Nsight Compute。

这部分还不熟悉,先简要介绍,后续深入研究。Nsight是NVIDIA面相开发者提供的开发工具套件,能提供深入的跟踪、调试、评测和分析,以优化跨NVIDIA GPU和CPU的复杂计算应用程序。Nsight主要包含Nsight System、Nsight Compute、Nsight Graphics三部分。

(1)Nsight System

所有与NVIDIA GPU相关的程序开发都可以从Nsight System开始以确定最大的优化机会。Nsight System给开发者一个系统级别的应用程序性能的可视化分析。开发人员可以优化瓶颈,以便在任意数量或大小的CPU和GPU之间实现高效扩展[4]。

(2)Nsight Compute

Nsight Compute是一个CUDA应用程序的交互式kernel分析器。它通过用户接口和命令行工具的形式提供了详细的性能分析度量和API调试。Nsight Compute还提供了定制化的和数据驱动的用户接口和度量集合,可以使用分析脚本对这些界面和度量集合进行扩展,以获得后处理的结果[5]。

(3)Nsight Graphics

Nsight Graphics是一个用于调试、评测和分析Microsoft Windows和Linux上的图形应用程序。它允许您优化基于Direct3D 11,Direct3D 12,DirectX,Raytracing 1.1,OpenGL,Vulkan和KHR Vulkan Ray Tracing Extension的应程序的性能[6]。

3.CUDA数据类型

CUDA支持多种数据类型,包括标准的C/C++数据类型以及特定于CUDA的数据类型。常见的CUDA数据类型,如下所示:

(1)基本数据类型(与C/C++相似)

int

float

double

char

unsigned int

short

long

unsigned char

unsigned short

unsigned long

bool

void

signed int或signed

signed char

signed short

signed long

signed long long

unsigned long long

复制(2)向量数据类型

int1, int2, int3, int4: 1到4个整数元素的向量。

float1, float2, float3, float4: 1到4个浮点数元素的向量。

double1, double2, double3, double4: 1到4个双精度浮点数元素的向量。

复制(3)复数数据类型

cuComplex: 单精度复数。

cuDoubleComplex: 双精度复数。

复制(4)CUDA数据类型修饰符

__device__: 用于声明在设备上执行的函数或变量。

__constant__: 用于声明常量内存。

__shared__: 用于声明共享内存。

__global__: 用于声明全局内核函数。

复制(5)CUDA特定的数据类型

dim3: 三维坐标,通常用于线程和块的索引。

cudaStream_t: 用于管理CUDA流。

cudaEvent_t: 用于事件同步。

texture<...>: 用于声明纹理内存,支持不同的数据类型和维度。

复制 除此之外CUDA还支持通过typedef和struct等方式定义自定义数据类型,以满足特定应用程序的需求。

4.C++数据类型

C++中数据类型完整列表,包括基本数据类型、复合数据类型和一些特殊数据类型,如下所示:

(1)基本数据类型

int

float

double

char

bool

void

wchar_t(宽字符类型)

short(或short int)

long(或long int)

long long(或long long int)

unsigned int

unsigned char

unsigned short

unsigned long

unsigned long long

复制(2)复合数据类型

array(数组)

struct(结构体)

union(联合体)

enum(枚举)

class(类)

复制(3)其它数据类型

signed(通常与int、char、short和long配合使用,表示有符号类型)

auto(C++11引入的自动类型推导)

decltype(C++11引入的类型推导)

nullptr(C++11引入的空指针)

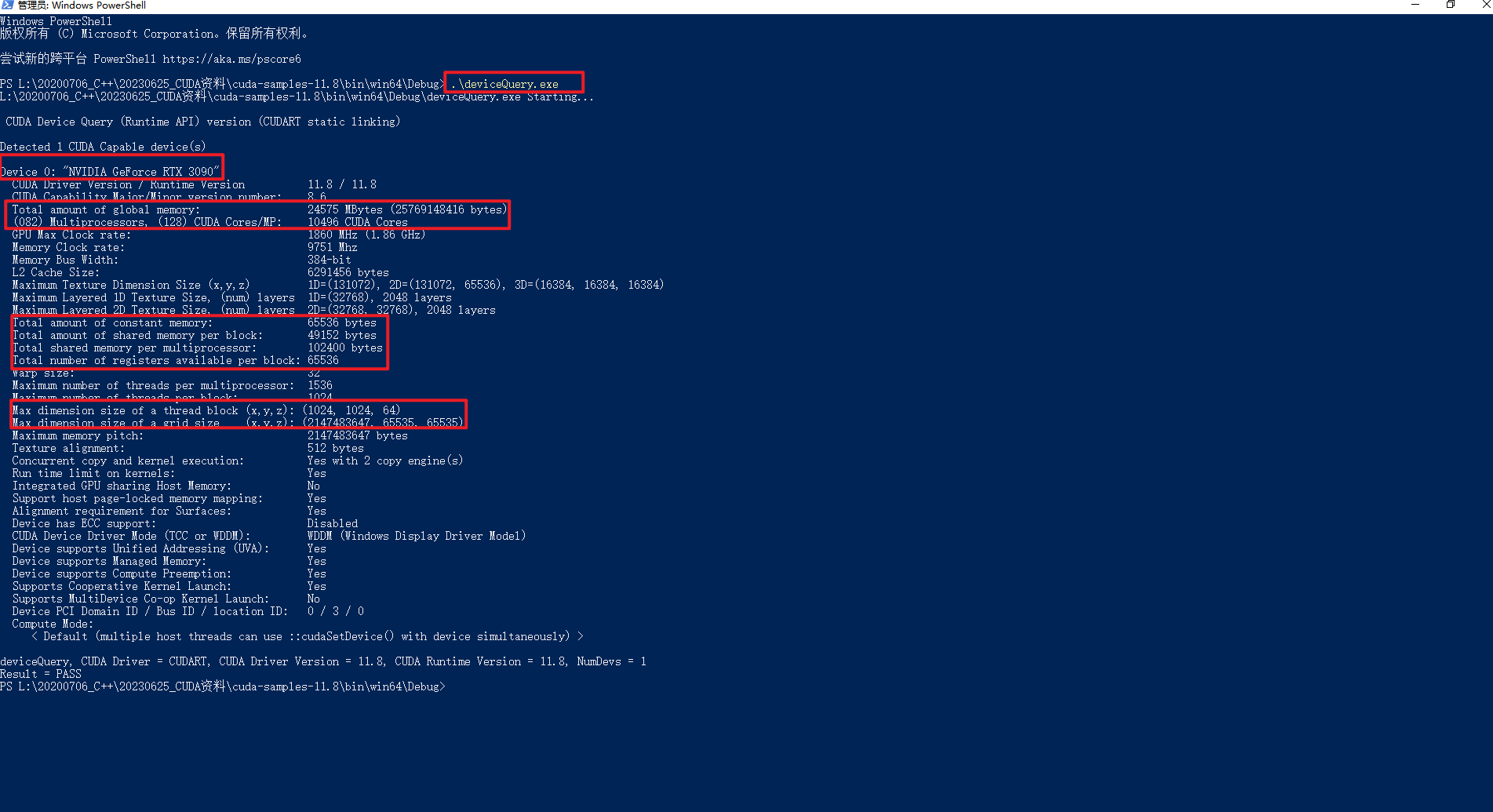

复制5.通过deviceQuery.exe查下设备信息

因为本地安装CUDA 11.8版本,所以下载https://github.com/NVIDIA/cuda-samples/releases/tag/v11.8,然后使用VS2022打开Samples_VS2022.sln编译,如下所示:

执行.\deviceQuery.exe后可以看到很多熟面孔的常量信息,如下所示:

参考文献:

[1]NVIDIA Developer Tools:https://developer.nvidia.com/tools-overview

[2]《CUDA C编程权威指南》

[3]使用Nsight工具分析优化应用程序:https://cloud.baidu.com/doc/GPU/s/el8mizux4

[4]https://developer.nvidia.com/nsight-systems

[5]https://developer.nvidia.com/nsight-compute

[6]https://developer.nvidia.com/nsight-graphics

[7]给核函数计时:https://github.com/ai408/nlp-engineering/tree/main/20230917_NLP工程化/20231004_高性能计算/20231003_CUDA编程/20231003_CUDA_C编程权威指南/2-CUDA编程模型/2.2-给核函数计时

在CUDA程序中, 访存优化个人认为是最重要的优化项. 往往kernel会卡在数据传输而不是计算上, 为了最大限度利用GPU的计算能力, 我们需要根据GPU硬件架构对kernel访存进行合理的编写.